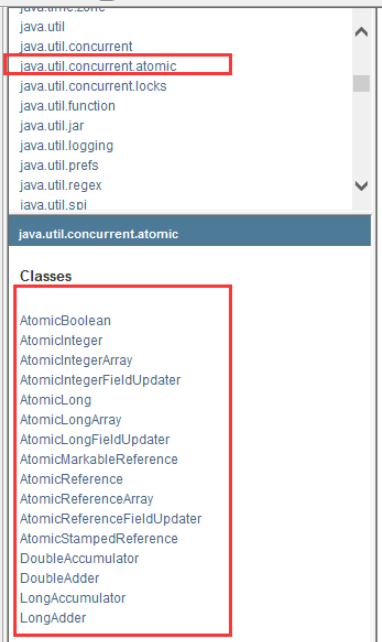

1、进程与线程 概述 在 Java 中,线程部分是一个重点,本篇文章说的 JUC 也是关于线程的。JUC就是 java.util .concurrent 工具包的简称。这是一个处理线程的工具包,JDK 1.5 开始出现的。

进程与线程 概述 进程 :指在系统中正在运行的一个应用程序;程序一旦运行就是进程;进程——资源分配的最小单位。

线程 :系统分配处理器时间资源的基本单元,或者说进程之内独立执行的一个单元执行流。线程——程序执行的最小单位。

一个java程序对应一个进程

一个进程对应一个jvm实例

一个 jvm实例中只有一个运行时数据区

一个运行时数据区只有一个方法区和堆

一个进程中的多个线程需要共享同一个方法区,堆空间

每一个线程在创建时都会创建一个虚拟机栈

每一个线程拥有独立的一套程序计数器,本地方法栈,虚拟机栈

每一个线程内部保存的一个个的栈帧对应着一次次的Java方法调用

补充 提问?JAVA真的可以开启线程吗? 开不了的!

public synchronized void start () { if (threadStatus != 0 ) throw new IllegalThreadStateException (); group.add(this ); boolean started = false ; try { start0(); started = true ; } finally { try { if (!started) { group.threadStartFailed(this ); } } catch (Throwable ignore) { } } } private native void start0 () ;

Java是没有权限去开启线程、操作硬件的,这是一个native的一个本地方法,它调用的底层的C++代码。

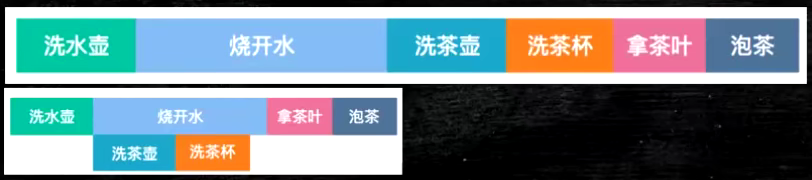

并发和并行 概述 并发 :多线程操作同一个资源。

CPU 只有一核,模拟出来多条线程,天下武功,唯快不破。那么我们就可以使用CPU快速交替,来模拟多线程。

并发(concurrent)指的是多个程序可以同时运行的现象,更细化的是多进程可以同时运行或者多指令可以同时运行

要解决大并发问题,通常是将大任务分解成多个小任务

并行 :多项工作一起执行

CPU多核,多个线程可以同时执行。 我们可以使用线程池!

public class Test1 { public static void main (String[] args) { System.out.println(Runtime.getRuntime().availableProcessors()); } }

串行

总结 并发编程的本质:充分利用CPU的资源!

线程的状态 public enum State {NEW,(新建) RUNNABLE,(运行) BLOCKED,(阻塞) WAITING,(不见不散等待) TIMED_WAITING,(过时不候——超时等待) TERMINATED;(终结) }

wait 和sleep的区别 基础 1、来自不同的类

sleep 是 Thread 的静态方法

wait 是 Object 的方法,任何对象实例都能调用。

一般情况企业中使用休眠是:

TimeUnit.DAYS.sleep(1 ); TimeUnit.SECONDS.sleep(1 );

2、关于锁的释放

sleep 不会释放锁,它也不需要占用锁。

wait 会释放锁,但调用它的前提是当前线程占有锁(即代码要在 synchronized 中)。

3、使用的范围是不同的

sleep 可以在任何地方睡;

wait 必须在同步代码块中;

4、是否需要捕获异常

sleep必须要捕获异常;

wait是不需要捕获异常;

5、它们都可以被 interrupted 方法中断

wait和sleep的区别与联系? 区别:

由于sleep针对的是线程,所以他在thread类中,wait的源码中用到了sync锁,所以是和对象有关的,因此他在object类中

wait和锁相关,所以他需要释放锁;sleep是线程不涉及锁,所以不需要释放锁

sleep必须捕获异常,wait()、notify、notifyAll不需要捕获异常

联系:

两者都会造成线程阻塞(因为对象依附于线程,wait是对线程加锁,所以会阻塞;sleep原本就作用于线程,因此也会造成阻塞)

两者均可被中断唤醒()

内容:

sleep方法导致了程序暂停执行指定的时间,让出CPU给其他线程,但是他的监控状态依旧保持着,时间一到就会恢复运行

调用sleep方法的时候,对象不会释放锁;而wait方法会放弃该对象的锁,将线程放入锁池,等待唤醒

管程 管程就是操作系统中进程同步的一种方式

管程(monitor)是保证了同一时刻只有一个进程在管程内活动,即管程内定义的操作在同一时刻只被一个进程调用(由编译器实现)。但是这样并不能保证进程以设计的顺序执行。

JVM 中同步是基于进入和退出管程(monitor)对象实现的,每个对象都会有一个管程(monitor)对象,管程(monitor)会随着java对象一同创建和销毁。

执行线程首先要持有管程对象,然后才能执行方法,当方法完成之后会释放管程,方法在执行时候会持有管程,其他线程无法再获取同一个管程。

管程特点: 管程封装了同步操作,对进程隐蔽了同步细节,简化了同步功能的调用界面。用户编写并发程序如同编写顺序(串行)程序。

引入管程机制的目的:

1、把分散在各进程中的临界区集中起来进行管理;

2、防止进程有意或无意的违法同步操作;

3、便于用高级语言来书写程序,也便于程序正确性验证。

组成部分

1)局部于管程的共享变量;

2)对数据结构进行操作的一组过程;

3)对局部于管程的数据进行初始化的语句。

管程的属性 共享性:管程可被系统范围内的进程互斥访问,属于共享资源

安全性:管程的局部变量只能由管程的过程访问,不允许进程或其它管程直接访问,管程也不能访问非局部于它的变量。

互斥性:多个进程对管程的访问是互斥的。任一时刻,管程中只能有一个活跃进程。

封装性:管程内的数据结构是私有的,只能在管程内使用,管程内的过程也只能使用管程内的数据结构。进程通过调用管程的过程使用临界资源。管程在Java中已实现。

用户线程和守护线程 用户线程 :平时用到的普通线程, 自定义线程

守护线程 :运行在后台,是一种特殊的线程,比如垃圾回收

当主线程结束后,用户线程还在运行JVM存活

如果没有用户线程,都是守护线程,JVM结束

2、Lock 接口 Synchronized关键字 概述 synchronized 是 Java 中的关键字,是一种同步锁。它修饰的对象有以下几种:

修饰一个代码块 ,被修饰的代码块称为同步语句块,其作用的范围是大括号{}括起来的代码,作用的对象是调用这个代码块的对象;

修饰一个方法 ,被修饰的方法称为同步方法,其作用的范围是整个方法,作用的对象是调用这个方法的对象;

修改一个静态的方法 ,其作用的范围是整个静态方法,作用的对象是这个类的所有对象;

修改一个类 ,其作用的范围是 synchronized 后面括号括起来的部分,作用主的对象是这个类的所有对象。

实例 public class SaleTicketDemo01 { public static void main (String[] args) { Ticket ticket = new Ticket (); new Thread (()->{ for (int i=0 ;i<40 ;i++){ ticket.sale(); } },"A" ).start(); new Thread (()->{ for (int i=0 ;i<40 ;i++){ ticket.sale(); } },"B" ).start(); new Thread (()->{ for (int i=0 ;i<40 ;i++){ ticket.sale(); } },"C" ).start(); } } class Ticket { private int number=50 ; public synchronized void sale () { if (number>0 ){ System.out.println(Thread.currentThread().getName()+" 卖出了第" +number+" 张票,剩余:" +number+" 张票" ); number--; } } }

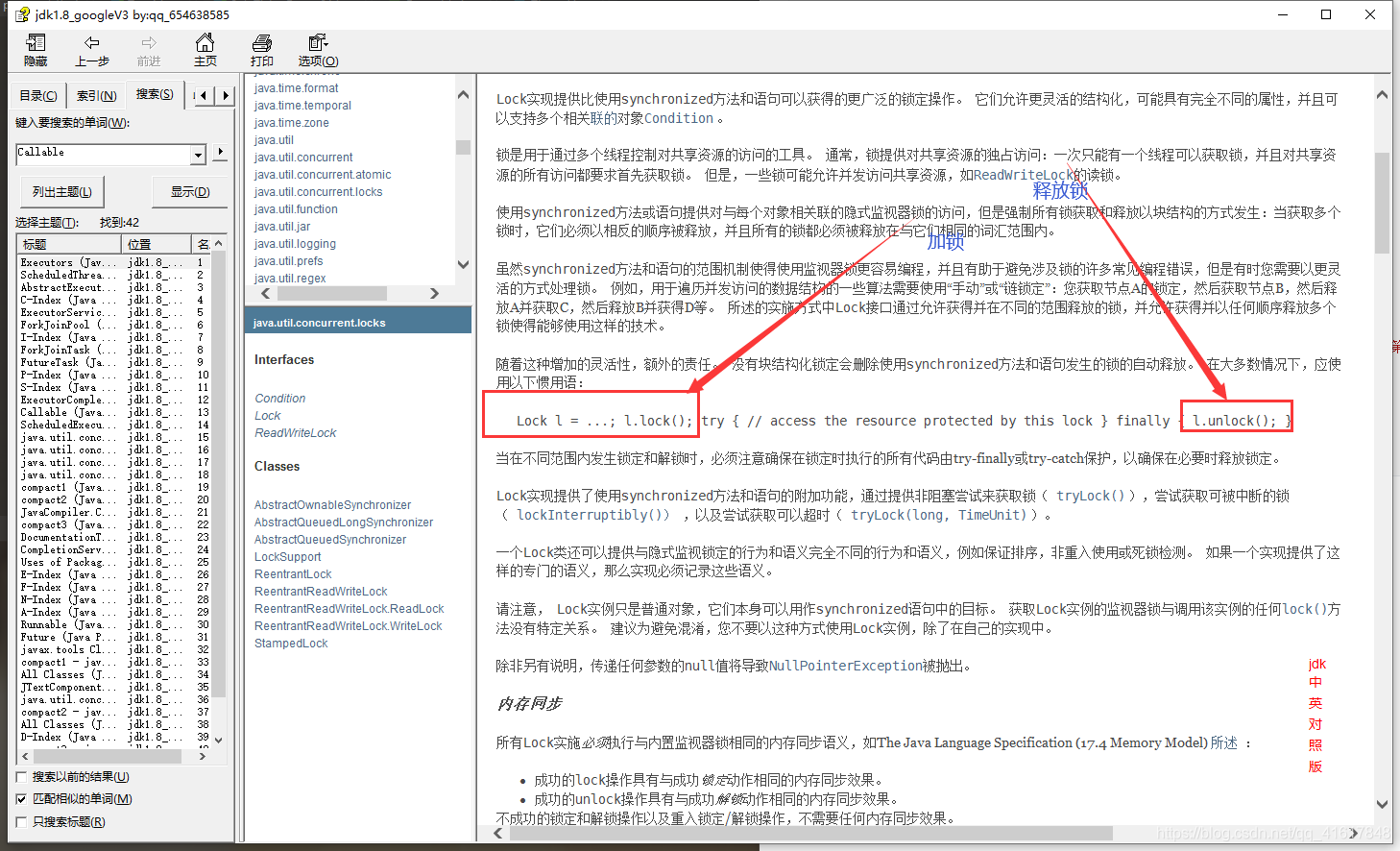

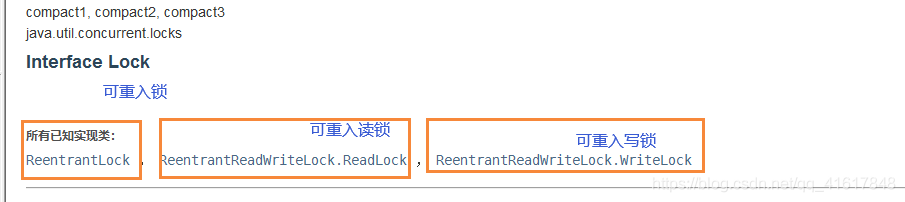

Lock 概述 Lock 锁实现提供了比使用同步方法和语句可以获得的更广泛的锁操作。它们允许更灵活的结构,可能具有非常不同的属性,并且可能支持多个关联的条件对象。Lock 提供了比 synchronized 更多的功能。

实例 public class SaleTicketDemo02 { public static void main (String[] args) { Ticket2 ticket = new Ticket2 (); new Thread (()->{for (int i=0 ;i<40 ;i++) ticket.sale(); },"A" ).start(); new Thread (()->{for (int i=0 ;i<40 ;i++) ticket.sale(); },"B" ).start(); new Thread (()->{for (int i=0 ;i<40 ;i++) ticket.sale(); },"C" ).start(); } } class Ticket2 { private int number=50 ; Lock lock=new ReentrantLock (); public void sale () { lock.lock(); try { if (number>=0 ){ System.out.println(Thread.currentThread().getName()+" 卖出了第" +number+" 张票,剩余:" +number+" 张票" ); number--; } }catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } }

Synchronized 和 Lock区别 1、Synchronized 内置的Java关键字,Lock是一个Java类

2、Synchronized 无法判断获取锁的状态,Lock可以判断

3、Synchronized 会自动释放锁,lock必须要手动加锁和手动释放锁!可能会遇到死锁

4、Synchronized 线程1(获得锁->阻塞)、线程2(等待);

lock就不一定会一直等待下去,lock会有一个trylock去尝试获取锁,不会造成长久的等待。

5、Synchronized 是可重入锁,不可以中断的,非公平的;Lock,可重入的,可以判断锁,可以自己设置公平锁和非公平锁;

6、Synchronized 适合锁少量的代码同步问题,Lock适合锁大量的同步代码;

在性能上来说,如果竞争资源不激烈,两者的性能是差不多的,二当竞争资源非常激烈时(即有大量线程同时竞争),此时Lock的性能要远远由于Synchronized。

补充 在jdk1.5以前sync对锁的处理十分的简单粗暴,为了优化性能在jdk1.5时,引入了lock锁。而且sync还有一个诟病就是无法同时使用wait和notify(原因是因为)

sync的加锁过程

在1.6之后,jdk对sync做了优化,引入了偏向锁、自旋锁等。加锁的过程也相对之前较为完善。为了让线程降低获取锁的成本,于是引入了偏向锁,偏向锁的锁头会从对象头的markwork区域获取并记录当前线程的id,他会将当前markwork信息复制到栈上。当别的线程来操作时,会首先对线程id进行判定是否当前线程在操作,在1.5之前如果获取失败会直接阻塞,在优化过后提出了自旋锁的概念,在获取失败后会通过cas自旋的方式再一次尝试获取到锁,在自旋超过10次以后该轻量级锁就会升级为重量级锁。

重量级锁相对于轻量级锁的区别就在于,重量级锁需要唤醒、阻塞、上下文切换等,主要针对于多个线程在不同时间请求同一把锁的情况。当升级为重量级锁时,会将该线程存放到等待队列中,等到被唤醒再一次去争抢锁

锁升级的原因:如果让当前线程阻塞,对性能的校会很大,如果使用自旋的话,当数据量小时自旋相当于就是让这些等待的线程去尝试获取锁。当线程很多在竞争时,就膨胀为重量级锁。因为不停地自旋也会影响性能。

上下文切换

线程运行时,会有自己的运行条件和状态,即上下文

主动让出 CPU,比如调用了 sleep(), wait() 等。

时间片用完,因为操作系统要防止一个线程或者进程长时间占用 CPU 导致其他线程或者进程饿死。

调用了阻塞类型的系统中断,比如请求 IO,线程被阻塞。

被终止或结束运行

发生线程切换时,线程切换意味着需要保存当前线程的上下文,留待线程下次占用 CPU 的时候恢复现场。并加载下一个将要占用 CPU 的线程上下文。这就是所谓的 上下文切换 。

lock的加锁过程

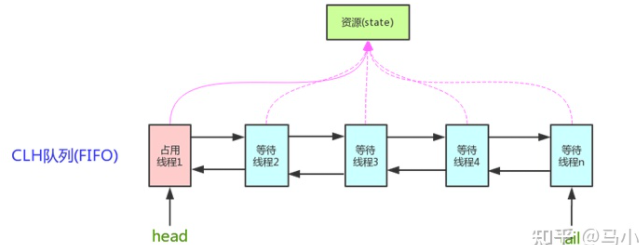

reentrentLock是cas基于aqs实现的,为了实现公平锁和非公平锁

无论是公平锁还是非公平锁,在线程启用lock锁时,所有的线程都会尝试通过cas的方式修改state参数,最终那个线程成功修改了state参数哪个线程就抢到了锁。

公平锁

如果设置成功,设置当前线程为独占锁的线程;

如果设置失败,还会再获取一次锁数量

如果锁数量为0,再基于CAS尝试1一次将state(锁数量)从0设置为,如果设置成功,设置当前线程为独占锁的线程;

如果锁数量不为0或者上边的尝试又失败了,查看当前线程是不是已经是独占锁的线程了,如果是,则将当前的锁数量+1;如果不是,则将该线程封装在一个Node内,并加入到等待队列中去。等待被其前一个线程节点唤醒。

非公平锁

获取一次锁数量,

如果锁数量为0,如果当前线程是等待队列中的头节点,基于CAS尝试一次将state(锁数量)从0设置为1,如果设置成功,设置当前线程为独占锁的线程;

如果锁数量不为0或者当前线程不是等待队列中的头节点或者上边的尝试又失败了,查看当前线程是不是已经是独占锁的线程了,如果是,则将当前的锁数量+1;如果不是,则将该线程封装在一个Node内,并加入到等待队列中去。等待被其前一个线程节点唤醒。

当A线程获取到锁之后进行执行中,将state+1,此时其他线程如果想要执行需要睡眠进行等待,等待A执行完毕后,释放锁后,获取到锁之后才可以执行。

reentrenLock实现公平锁和非公平锁的不同就是在加入队列后,当前节点是否有前驱节点的判断,如果不是头结点的下一个节点,就乖乖排队,去其他线程中查找符合条件的。非公平锁直接cas,公平锁会就进行判断

公平锁保证了锁的获取按照FIFO原则,而代价是进行大量的线程切换。非公平锁虽然可能造成线程“饥饿”,但极少的线程切换,保证了其更大的吞吐量。

ReentrantReadWriteLock 基础 基于AQS实现的。

AQS就一个state属性,怎么基于一个state实现的互斥锁和共享锁。

但是它有读锁和写锁俩种状态,而AQS只有一个状态变量。所以高16位作为共享锁的实现 低16位作为互斥锁的实现

读写锁是可重入的,写锁因为是互斥,直接追加到低位即可。

但是读锁是共享的,读锁的重入是如何实现的?

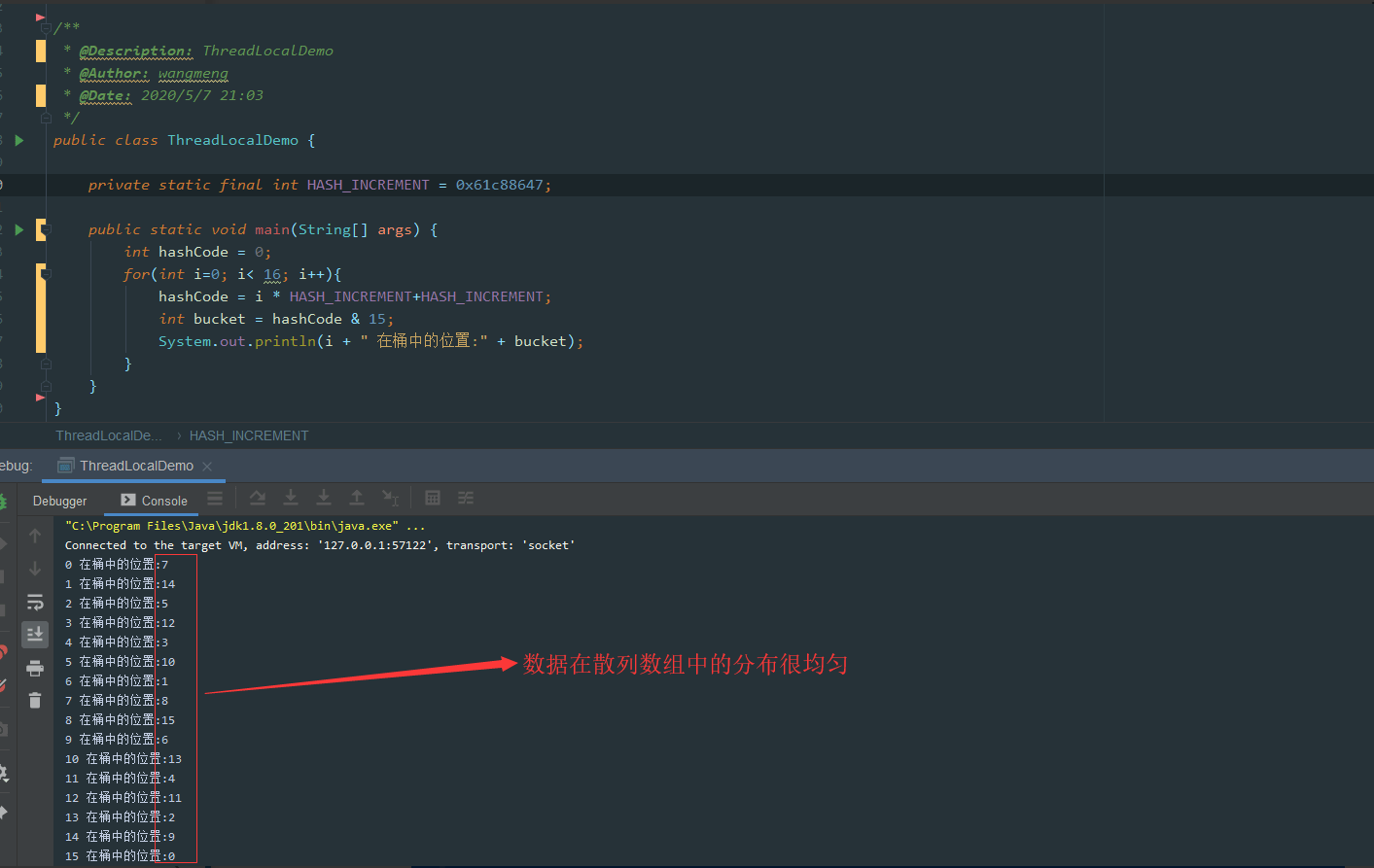

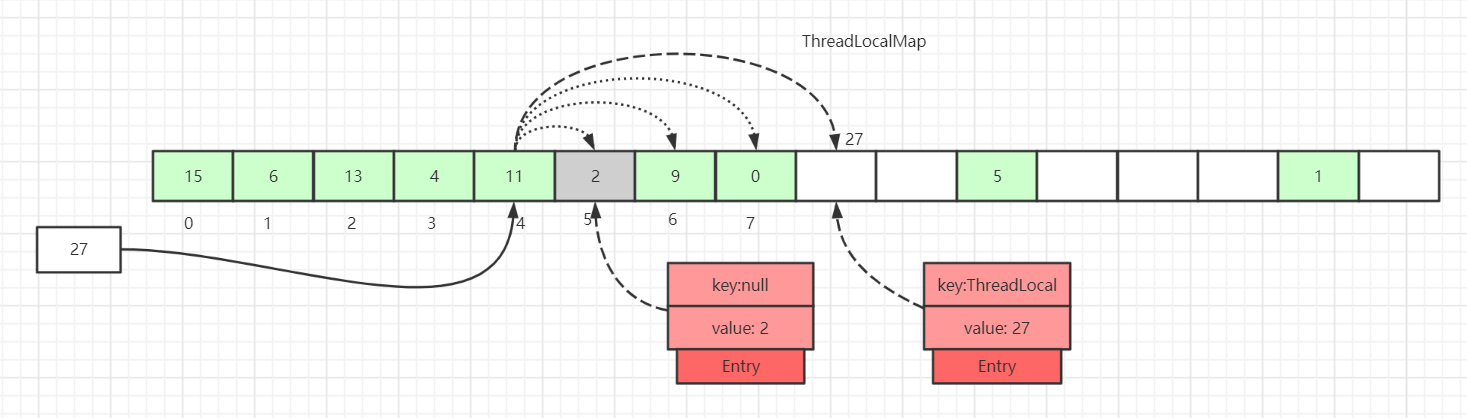

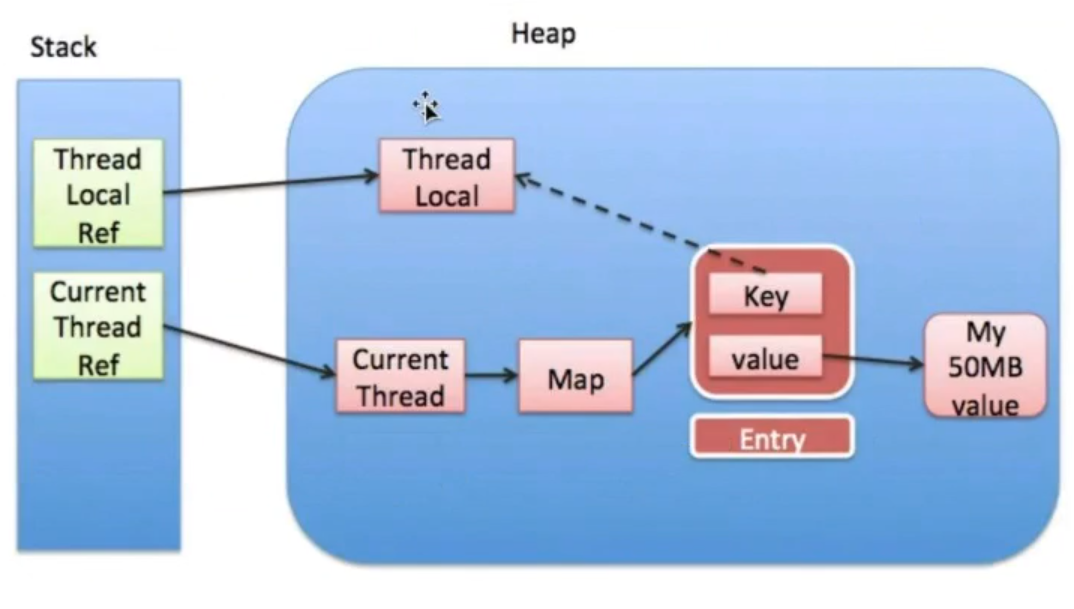

因为读锁都会操作state的高16位,为了记录当前线程重入的次数,需要配合ThreadLocal实现。(自己线程的锁信息会保留在线程的ThreadLocal中。)

因为读锁是共享的,所以多个读线程进来可以直接获取到读锁,如果在读线程中,有一个写线程在排队,是不是会造成写锁的饥饿呢?

如果有写线程在AQS的队列中排队,那么读线程就不能直接获取读锁,要在写线程后面排队,避免写锁饥饿。

读写锁如何实现读锁的重入? 因为读锁都会操作state的高16位,为了记录当前线程重入的次数,需要配合ThreadLocal实现。(自己线程的锁信息会保留在线程的ThreadLocal中。)

对读锁的重入做了哪些优化? 每个线程如果要记录读锁的重入,需要配合threadlocal,threadlocal会初始化一个16位的entry数组

但是ThreadLocal有个特点,上来就初始化16长度Entry数组,每次记录读锁需要拿到ThreadLocal中的值,进行+ +或者–。同时还需要解决ThreadLocal中value的内存泄漏问题。

读锁针对第一个成功获取读锁的线程,不需要去基于ThreadLocal记录,直接使用读写锁内部提供的属性去记录读锁线程和读多重入次数。

private transient Thread firstReader = nu11; private transient int firstReaderHoldCount ;

读锁还针对最后一个获取读锁的线程, 单路的将HoldCounter从ThreadLocal中取出, 放到属性中,以后就不需要反复的从ThreadLocal获取

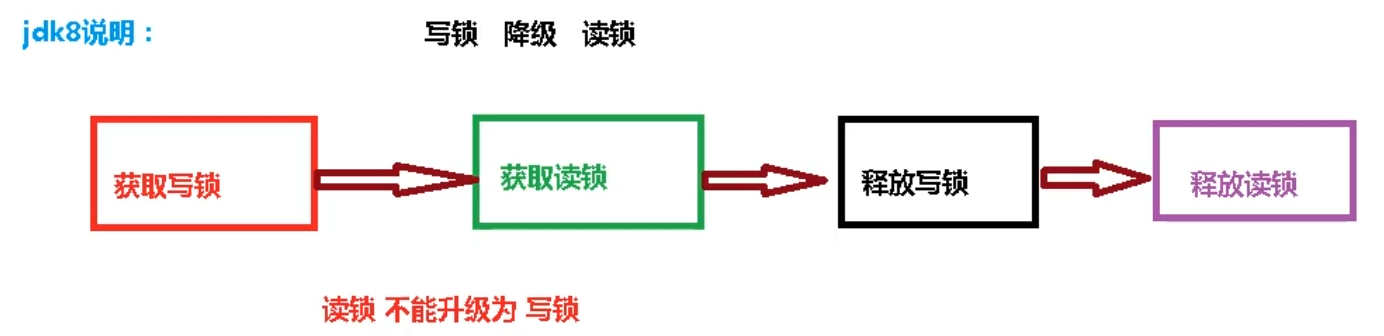

锁降级 锁降级指的是写锁降级成为读锁。如果当前线程拥有写锁,然后将其释放,最后再获取读锁,这种分段完成的过程不能称之为锁降级。锁降级是指把持住(当前拥有的)写锁,再获取到读锁,随后释放(先前拥有的)写锁的过程。

锁降级的必要性

主要是为了保证数据的可见性,如果当前线程不获取读锁而是直接释放写锁, 假设此刻另一个线程(记作线程T)获取了写锁并修改了数据,那么当前线程无法感知线程T的数据更新。如果当前线程获取读锁,即遵循锁降级的步骤,则线程T将会被阻塞,直到当前线程使用数据并释放读锁之后,线程T才能获取写锁进行数据更新。

实现

使用ReentrantReadWriteLock实现锁降级

package com.xz.thread.t12;import java.util.HashMap;import java.util.Map;import java.util.concurrent.locks.Lock;import java.util.concurrent.locks.ReadWriteLock;import java.util.concurrent.locks.ReentrantReadWriteLock;public class Demo { private ReadWriteLock rwl = new ReentrantReadWriteLock (); private Lock r = rwl.readLock(); private Lock w = rwl.writeLock(); private Map<String,Object> map =new HashMap <>(); private volatile boolean isUpdateStatus; public void readWriteMethod () { r.lock(); if (isUpdateStatus){ r.unlock(); w.lock(); map.put("key1" ,"v1" ); r.lock(); w.unlock(); } Object obj = map.get("key1" ); r.unlock(); System.out.println(Thread.currentThread().getName()+"读操作获取到的值:" +obj); } }

总结

首先你没理解读写锁的意义,读锁的存在意味着不允许其他写操作的存在。

按照你提供的例子,可能存在一个事务线程不希望自己的操作被别的线程中断,而这个事务操作可能分成多部分操作更新不同的数据(或表)甚至非常耗时。如果长时间用写锁独占,显然对于某些高响应的应用是不允许的,所以在完成部分写操作后,退而使用读锁降级,来允许响应其他进程的读操作。只有当全部事务完成后才真正释放锁。

所以总结下锁降级的意义应该就是:在一边读一边写的情况下提高性能。

3、线程间通信 生产者和消费者问题 Synchronized版本 public class A { public static void main (String[] args) { Data data = new Data (); new Thread (()->{for (int i=0 ;i<10 ;i++) { try { data.increment(); } catch (InterruptedException e) { e.printStackTrace(); } } },"A" ).start(); new Thread (()->{for (int i=0 ;i<10 ;i++) { try { data.decrement(); } catch (InterruptedException e) { e.printStackTrace(); } }},"B" ).start(); } } class Data { private int number = 0 ; public synchronized void increment () throws InterruptedException { if (number!=0 ){ this .wait(); } number++; System.out.println(Thread.currentThread().getName()+"=>" +number); this .notifyAll(); } public synchronized void decrement () throws InterruptedException { if (number==0 ){ this .wait(); } number--; System.out.println(Thread.currentThread().getName()+"=>" +number); this .notifyAll(); } }

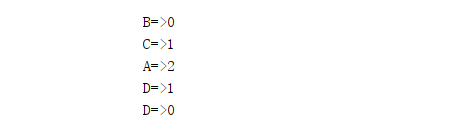

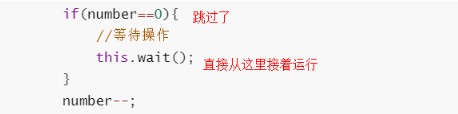

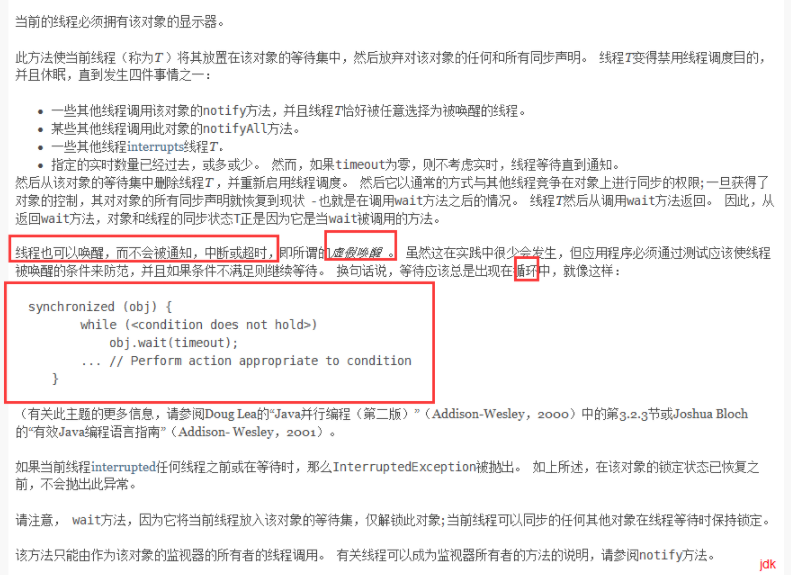

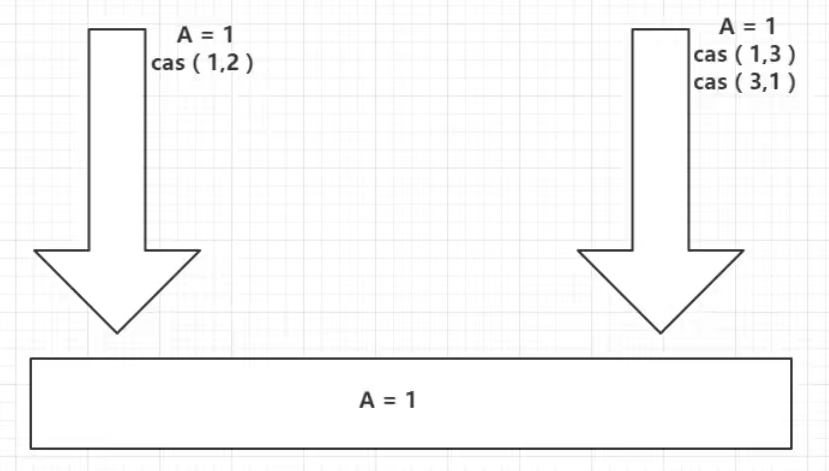

问题存在,A线程B线程,现在如果我有四个线程A B C D!就会出现以下情况,即虚假唤醒:

虚假唤醒

产生的主要原因是因为,wait方法在哪里睡在哪里醒,会跳过条件判断

解决方法

把Data类中的if改为while即可,防止虚拟唤醒

class Data { private int number = 0 ; public synchronized void increment () throws InterruptedException { while (number!=0 ){ this .wait(); } number++; System.out.println(Thread.currentThread().getName()+"=>" +number); this .notifyAll(); } public synchronized void decrement () throws InterruptedException { while (number==0 ){ this .wait(); } number--; System.out.println(Thread.currentThread().getName()+"=>" +number); this .notifyAll(); } }

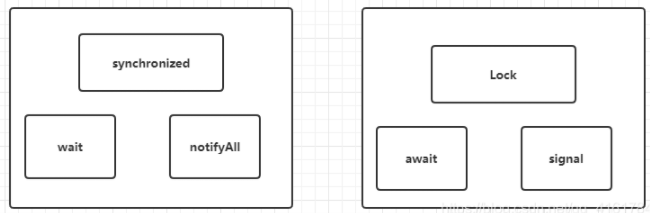

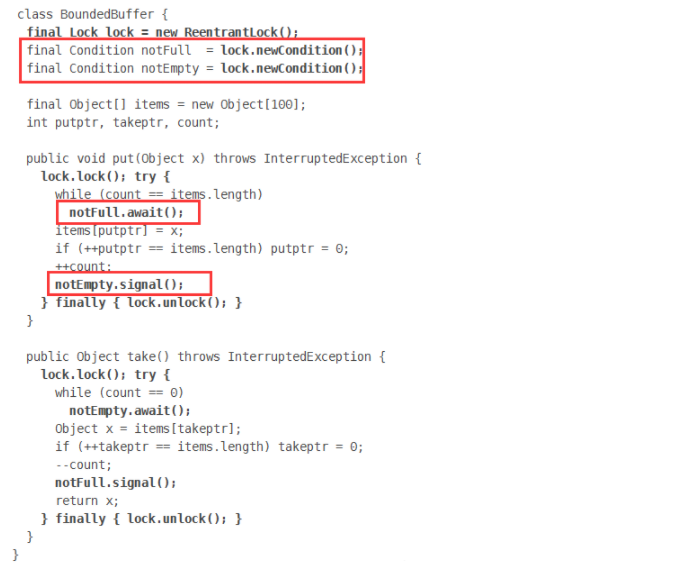

JUC版本 await、signal 替换 wait、notify

通过Lock找到Condition

public class B { public static void main (String[] args) { Data2 data = new Data2 (); new Thread (()->{for (int i=0 ;i<10 ;i++) { data.increment(); } },"A" ).start(); new Thread (()->{for (int i=0 ;i<10 ;i++) { data.decrement(); }},"B" ).start(); new Thread (()->{for (int i=0 ;i<10 ;i++) { data.increment(); } },"C" ).start(); new Thread (()->{for (int i=0 ;i<10 ;i++) { data.decrement(); } },"D" ).start(); } } class Data2 { private int number = 0 ; Lock lock = new ReentrantLock (); Condition condition = lock.newCondition(); public void increment () { lock.lock(); try { while (number!=0 ){ condition.await(); } number++; System.out.println(Thread.currentThread().getName()+"=>" +number); condition.signalAll(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } public void decrement () { lock.lock(); try { while (number==0 ){ condition.await(); } number--; System.out.println(Thread.currentThread().getName()+"=>" +number); condition.signalAll(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } }

Condition Condition的优势 :精准的通知和唤醒的线程!

如果我们要指定通知的下一个进行顺序怎么办呢? 我们可以使用Condition来指定通知进程~

实例1 public class C { public static void main (String[] args) { Data3 data3 = new Data3 (); new Thread (()->{ for (int i=0 ;i<10 ;i++){ data3.printA(); } },"A" ).start(); new Thread (()->{ for (int i=0 ;i<10 ;i++){ data3.printB(); } },"B" ).start(); new Thread (()->{ for (int i=0 ;i<10 ;i++){ data3.printC(); } },"C" ).start(); } } class Data3 { private Lock lock=new ReentrantLock (); private Condition condition1 = lock.newCondition(); private Condition condition2 = lock.newCondition(); private Condition condition3 = lock.newCondition(); private int number = 1 ; public void printA () { lock.lock(); try { while (number!=1 ){ condition1.await(); } System.out.println(Thread.currentThread().getName()+",AAAAA" ); number=2 ; condition2.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } public void printB () { lock.lock(); try { while (number!=2 ){ condition2.await(); } System.out.println(Thread.currentThread().getName()+",BBBBB" ); number=3 ; condition3.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } public void printC () { lock.lock(); try { while (number!=3 ){ condition3.await(); } System.out.println(Thread.currentThread().getName()+",CCCCC" ); number=1 ; condition1.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } }

实例2 import java.util.concurrent.locks.Condition;import java.util.concurrent.locks.Lock;import java.util.concurrent.locks.ReentrantLock;class DemoClass { private int number = 0 ; private Lock lock = new ReentrantLock (); private Condition conditionA = lock.newCondition(); private Condition conditionB = lock.newCondition(); private Condition conditionC = lock.newCondition(); public void printA (int j) { try { lock.lock(); while (number != 0 ) { conditionA.await(); } System.out.println(Thread.currentThread().getName() + "输出 A,第" + j + " 轮开始" ); for (int i = 0 ; i < 5 ; i++) { System.out.println("A" ); } number = 1 ; conditionB.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } public void printB (int j) { try { lock.lock(); while (number != 1 ) { conditionB.await(); } System.out.println(Thread.currentThread().getName() + "输出 B,第" + j + " 轮开始" ); for (int i = 0 ; i < 10 ; i++) { System.out.println("B" ); } number = 2 ; conditionC.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } public void printC (int j) { try { lock.lock(); while (number != 2 ) { conditionC.await(); } System.out.println(Thread.currentThread().getName() + "输出 C,第" + j + " 轮开始" ); for (int i = 0 ; i < 15 ; i++) { System.out.println("C" ); } System.out.println("-----------------------------------------" ); number = 0 ; conditionA.signal(); } catch (Exception e) { e.printStackTrace(); } finally { lock.unlock(); } } } class TestVolatile { public static void main (String[] args) { DemoClass demoClass = new DemoClass (); new Thread (() -> { for (int i = 1 ; i <= 10 ; i++) { demoClass.printA(i); } }, "A 线程" ).start(); new Thread (() -> { for (int i = 1 ; i <= 10 ; i++) { demoClass.printB(i); } }, "B 线程" ).start(); new Thread (() -> { for (int i = 1 ; i <= 10 ; i++) { demoClass.printC(i); } }, "C 线程" ).start(); } }

总结 Synchronized实现同步的基础:java中的每一个对象都可以作为锁,具体表现为以下三种形式。

对于普通同步方法,锁是当前实例对象。

对于静态同步方法,锁是当前类的Class对象

对于同步方法块,锁是Synchronized括号里的配置的对象

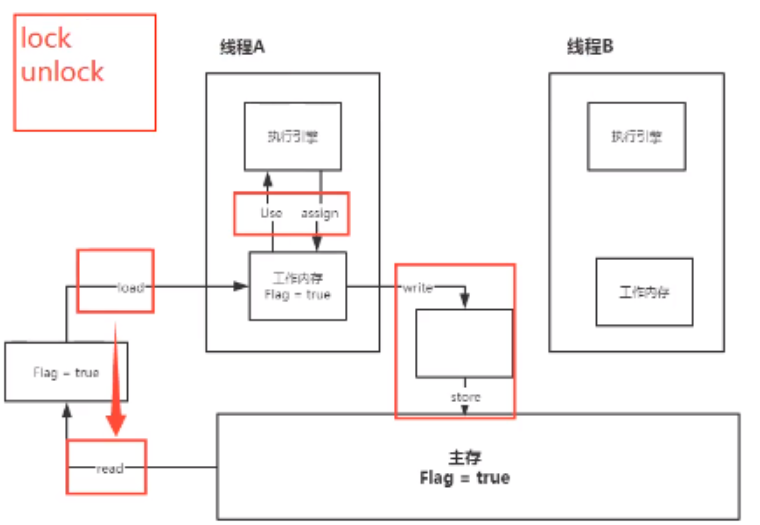

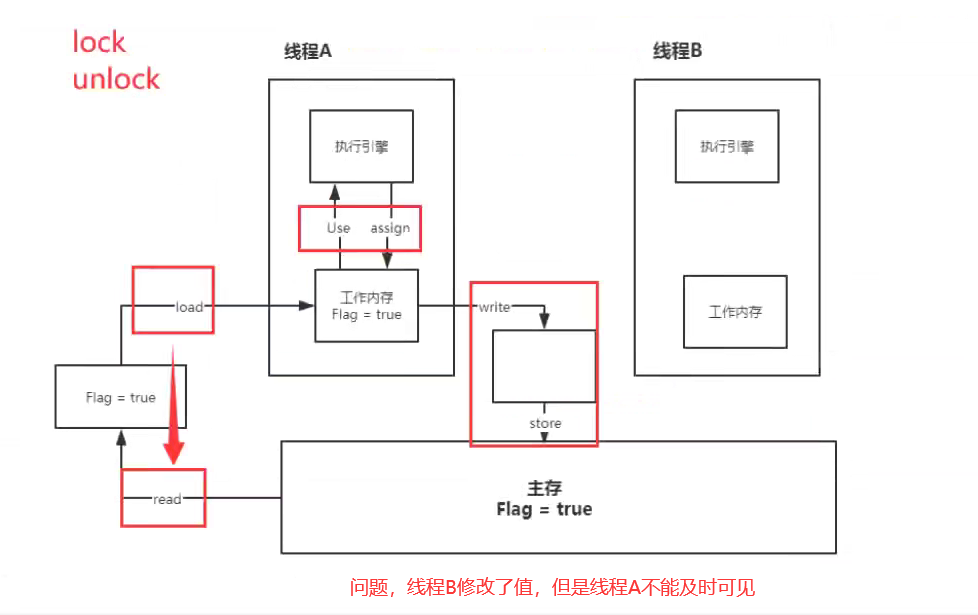

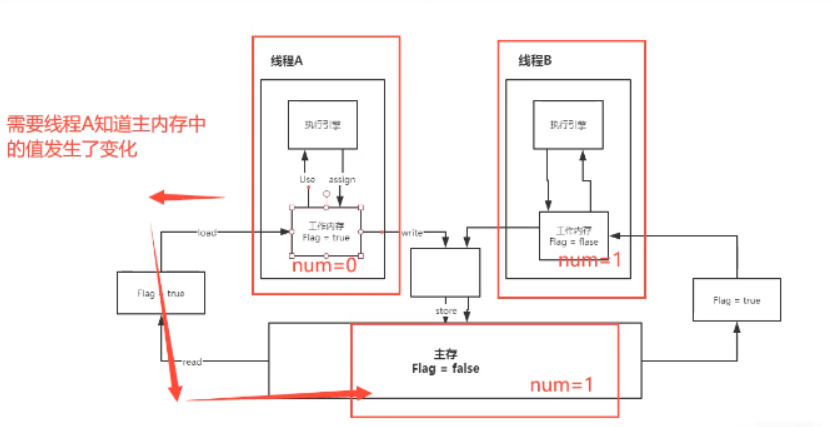

多线程之间是如何通信的? 为了实现可见性

操作系统:多进程:信号量、MQ、套接字、管道(有名管道、无名管道)、共享内存

由于多线程之间共享了进程的地址空间,所以原生就支持数据共享,当一个线程修改了进程变量,由于共享空间,另外一个线程自然能看到,所以原生支持通讯。由于线程之间并发必然会引起互斥操作,这是就需要同步机制:volitile、sync、lock…

使用volitile关键字

多个线程同时监听一个变量,当这个变量发生变化的时候 ,线程能够感知并执行相应的业务

使用object类的wait和notify方法

锁池、等待池

JUC的CountDownLatch

CountDownLatch 基于 AQS 框架,相当于也是维护了一个线程间共享变量 state。

reentrantLock+Condition

类似于第二种object的

LockSupport

是一种非常灵活的实现线程间阻塞和唤醒的工具,使用它不用关注是等待线程先进行还是唤醒线程先运行,但是得知道线程的名字。

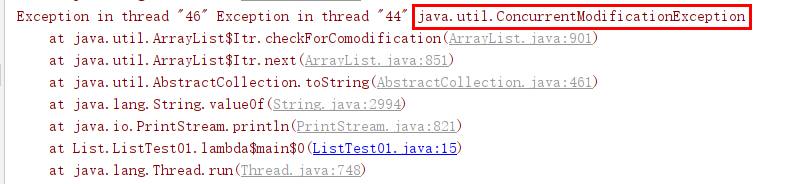

4、集合的线程安全 List集合不安全 问题 我们来看一下List这个集合类:

public class ListTest { public static void main (String[] args) { List<Object> arrayList = new ArrayList <>(); for (int i=1 ;i<=10 ;i++){ new Thread (()->{ arrayList.add(UUID.randomUUID().toString().substring(0 ,5 )); System.out.println(arrayList); },String.valueOf(i)).start(); } } }

会造成:

ArrayList 在并发情况下是不安全的!

原因 查看 ArrayList 的 add 方法源码

public boolean add (E e) {ensureCapacityInternal(size + 1 ); elementData[size++] = e; return true ; }

没有Synchronized关键字,该方法线程不安全。

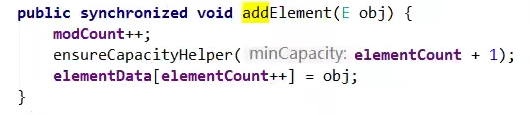

解决方法 Vector 切换成Vector就是线程安全的啦!

public class ListTest02 { public static void main (String[] args) { List<Object> arrayList = new Vector <>(); for (int i=1 ;i<=100 ;i++){ new Thread (()->{ arrayList.add(UUID.randomUUID().toString().substring(0 ,5 )); System.out.println(arrayList); },String.valueOf(i)).start(); } } }

Vector 是矢量队列 ,它是 JDK1.0 版本添加的类。继承于 AbstractList,实现了 List, RandomAccess, Cloneable 这些接口。 Vector 继AbstractList,实现了 List;所以,它是一个队列,支持相关的添加、删除、修改、遍历等功能 。 Vector 实现了 RandmoAccess 接口,即提供了随机访问功能 。RandmoAccess 是 java 中用来被 List 实现,为 List 提供快速访问功能的。在Vector 中,我们即可以通过元素的序号快速获取元素对象;这就是快速随机访问。 Vector 实现了 Cloneable 接口,即实现 clone()函数。它能被克隆。

Collections 2、使用Collections.synchronizedList(new ArrayList<>());

public class ListTest03 { public static void main (String[] args) { List<Object> arrayList = Collections.synchronizedList(new ArrayList <>()); for (int i = 1 ; i <= 100 ; i++) { new Thread (() -> { arrayList.add(UUID.randomUUID().toString().substring(0 , 5 )); System.out.println(arrayList); }, String.valueOf(i)).start(); } } }

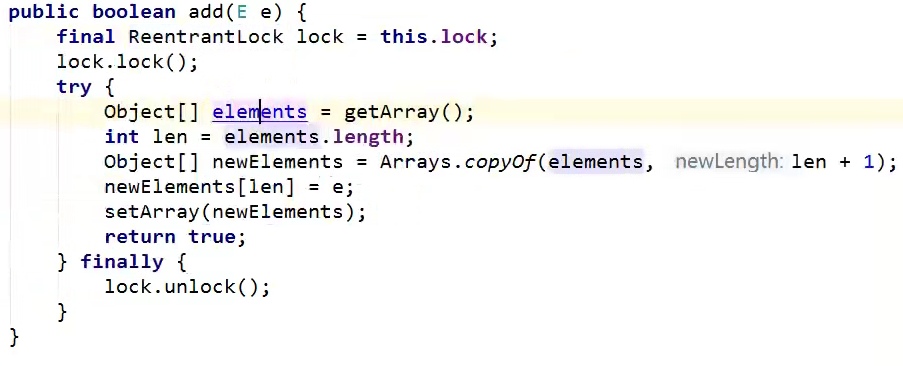

JUC 3、使用JUC中的包:List arrayList = new CopyOnWriteArrayList<>();

public class ListTest04 { public static void main (String[] args) { List<Object> arrayList = new CopyOnWriteArrayList <>(); for (int i = 1 ; i <= 10 ; i++) { new Thread (() -> { arrayList.add(UUID.randomUUID().toString().substring(0 , 5 )); System.out.println(arrayList); }, String.valueOf(i)).start(); } } }

CopyOnWriterArrayList和Vector对比 CopyOnWriterArrayList:

Vetocr:

Synchronized修饰的方法效率都很低,而CopyOnWriterArrayList中的方法都没有用到Synchronized修饰。

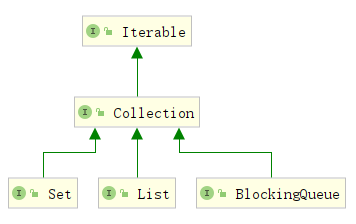

Set集合不安全 概述

和List、Set同级的还有一个BlockingQueue 阻塞队列;

Set和List同理可得: 多线程情况下,普通的Set集合是线程不安全的;

解决方法

使用Collections工具类的synchronized 包装的Set类

使用CopyOnWriteArraySet写入复制的JUC 解决方案

public class SetTest { public static void main (String[] args) { Set<String> hashSet = new CopyOnWriteArraySet <>(); for (int i = 1 ; i < 100 ; i++) { new Thread (()->{ hashSet.add(UUID.randomUUID().toString().substring(0 ,5 )); System.out.println(hashSet); },String.valueOf(i)).start(); } } }

HashSet底层是什么? public HashSet () { map = new HashMap <>(); } public boolean add (E e) { return map.put(e, PRESENT)==null ; } private static final Object PRESENT = new Object ();

hashSet底层就是一个HashMap ;

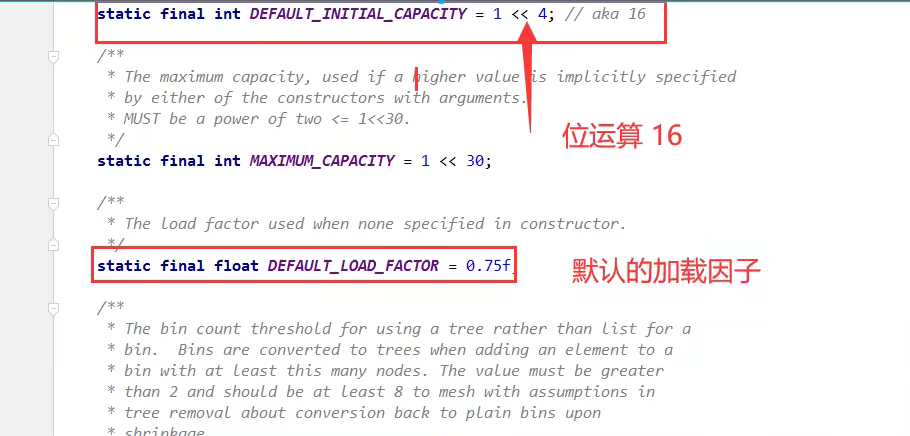

Map集合不安全 概述 回顾map的基本操作:

//map 是这样用的吗? 不是,工作中不使用这个

默认加载因子是0.75 ,默认的初始容量是16

问题 同样的HashMap基础类也存在并发修改异常 !

public static void main (String[] args) { Map<String, String> map = new HashMap <>(); for (int i = 1 ; i < 100 ; i++) { new Thread (()->{ map.put(Thread.currentThread().getName(),UUID.randomUUID().toString().substring(0 ,5 )); System.out.println(map); },String.valueOf(i)).start(); } }

解决方法

使用Collections.synchronizedMap(new HashMap<>());处理 ;使用ConcurrentHashMap进行并发处理

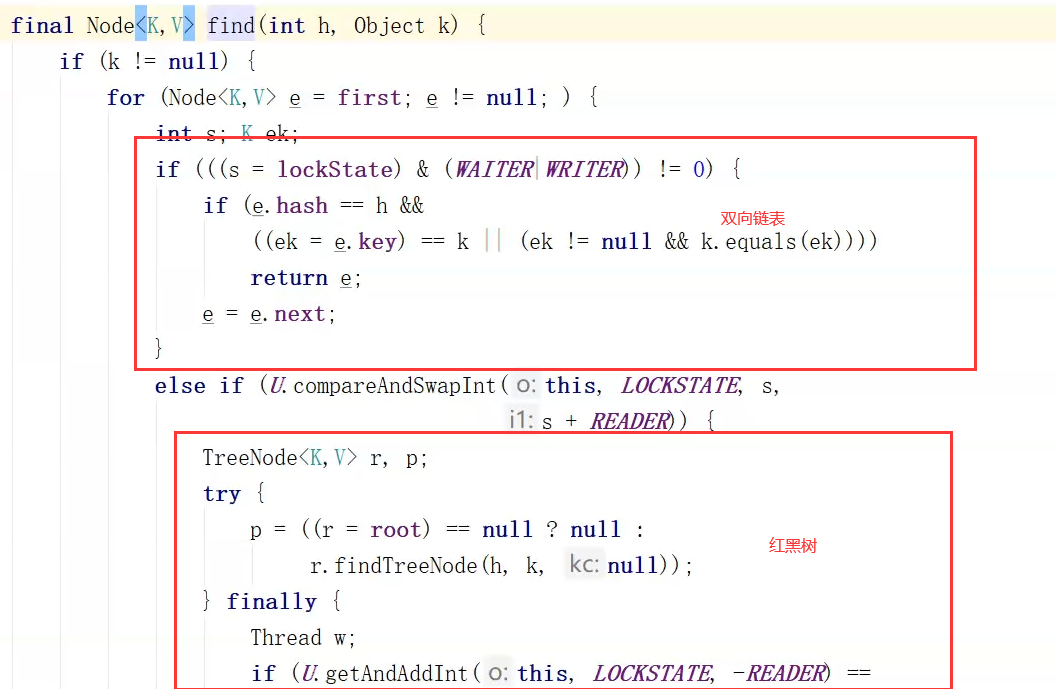

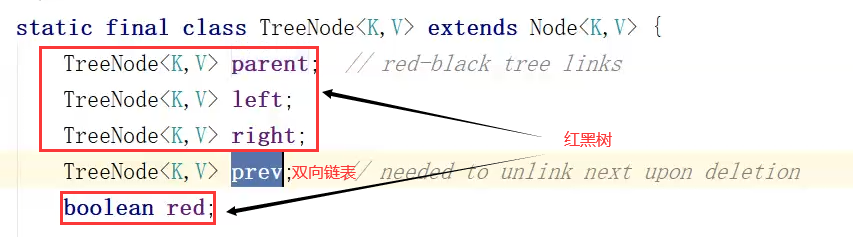

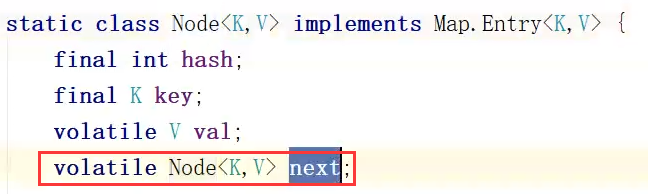

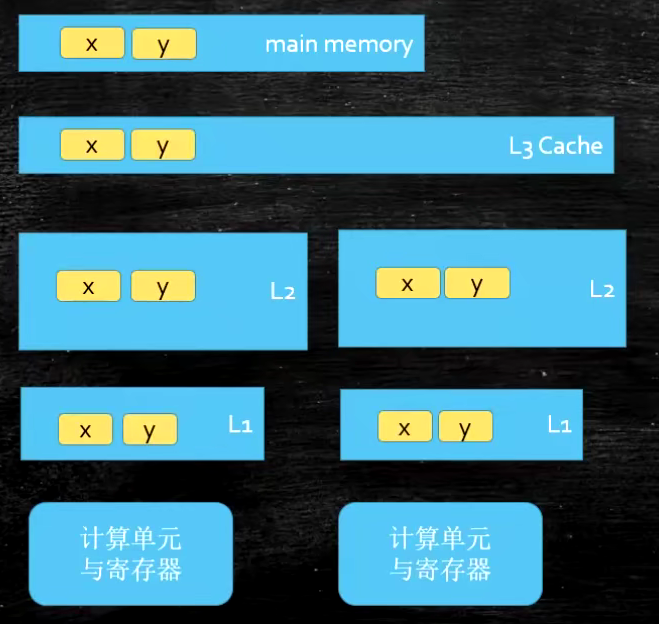

ConcurrentHashMap 数据结构 1.8 数组+链表+红黑树

1.7数组+链表

为什么 红黑树?

链表的话,查询的时间复杂度为On,链表过长,查询速度慢;

当链表长度到达8的时候就会从链表编程红黑树,红黑树的复杂度是Ologn;

链表长度为8时,一定要转换成红黑树吗?

必须达到数组长度》=64,并且某一个桶下的链表长度到8,才回转化成红黑树,数组查询效率快

为什么在8的时候才会转成红黑树?

泊松分布

什么时候转换回来?

6个

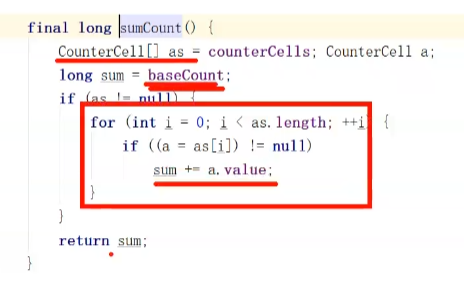

计数器 计数器是用来记录原子个数的,put了一个,计数器+1,remove了一个,计数器-1

CHM要保证是线程安全的

为了保证+1、-1是原子性的,如果采用了Atmoic,在大并发的情况下,会不会造成CAS自选次数过多呢?

CHM采用的是LongAdder作为计数器的实现

并没有直接引用LongAdder,而是仿照LongAdder源码又实现了一份

实现:

在CHM底层有一个addCount方法,而CHM的计数就是对baseCount参数的调整。为了避免并发量特别大时,无法保证线程安全,CHM创建了一个CountCell数组,数组中也有一个value元素。

当并发不大的时候,直接对baseCount元素做操作;若并发量很大/cas操作失败时,就构建CountCell数组,对其中的value进行操作,最终的计数=baseCount+多个CountCell数组

分段存储元素个数

散列算法 chm存储数据的位置有三种:

数组 O1(放在数组上的查询效率是最快的)

链表 On

红黑树 OlogN

chm本身就是为了让查询效率更快,因此当数据尽可能的放在数组上时,查询效率就是最快的。

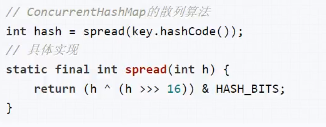

chm是key基于hashCode值,决定存储在哪个位置的

假设k1的hash:01010101 01010101 01010101 01010101

假设k2的hash:11111111 11111111 11111111 01010101

长度 - 1: 00000000 00000000 00000000 00001111

计算的方式:将hash值,与数组长度-1做&运行

如果单纯按照上述方式计算,会导致只要hash值的低位一样造成数据放在一个索引位置。因为低位的运算不影响高位(前16位获得的数据是不一样的,后16位运算完之后是一样的)

chm的处理方式

高低位一起运算

(hash ^ ( hash >>> 16)) & (tableSize -1)

对hashCode进行一个位运算。

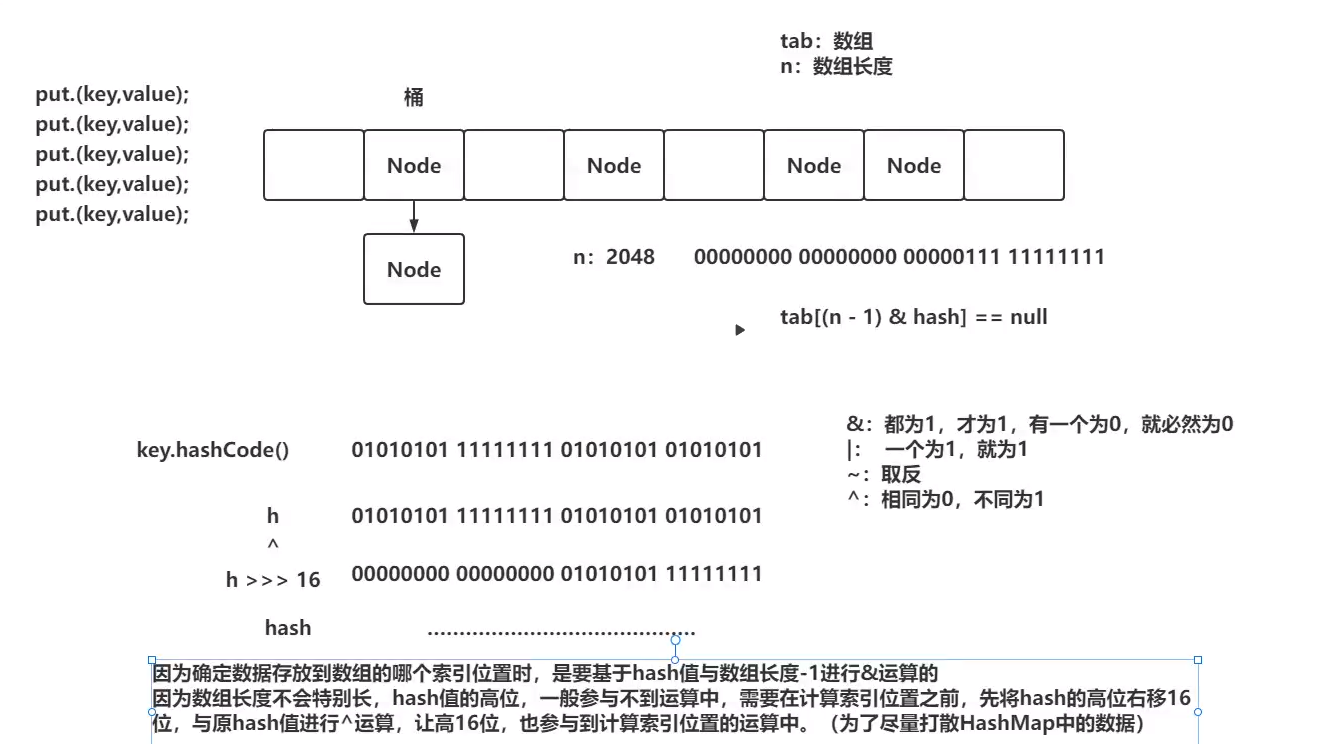

会先查双向链表,再查红黑树

线程A在写入红黑树ing,线程B要查询红黑树中的数据?读线程阻塞吗?

不阻塞

在链表转红黑树时,不单会将单向链表保留为红黑树,还会保留一个双向链表在红黑树中。如果有线程在写入红黑树时,其他直接去查询双向链表

chm还保留了双向链表,可以直接去查双向链表

整个过程是:先拼接双向链表,再转红黑树

如果有读线程读取红黑树数据,此时写线程要写入红黑树数据,写线程阻塞吗?

阻塞

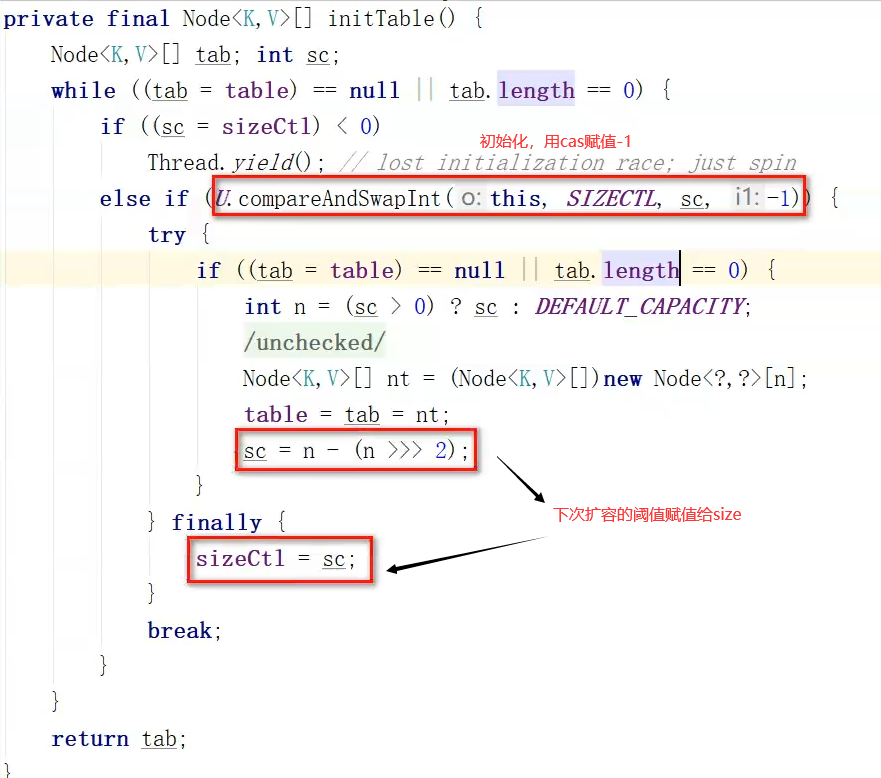

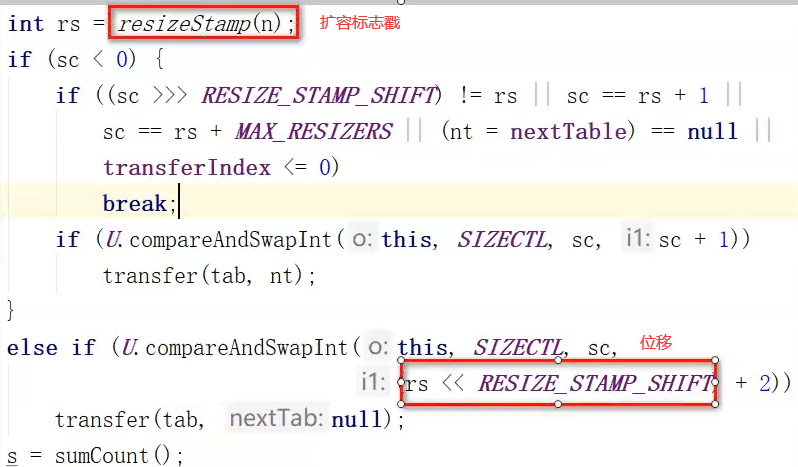

扩容 sizeCtl 用来控制初始化和扩容的参数

线程扩容时,会使用sizeCtl记录现在扩容时的线程数量,那么为什么1个线程扩容时,低位数值为2, 2个线程扩容为3?

**sizeCtl = -1:**代表当前ConcurrentHashMap的数组正在初始化

**sizeCtl < -1:**代表当前ConcurrentHashMap正在扩容,值为-2,代表有1个线程在扩容

**sizeCtl = 0:**代表当前还没初始化呢

sizeCtl > 0 :如果还没初始化,代表初始数组长度。如果已经初始化了, 就代表扩容阈值

ConcurrentHashMap在第一次put操作时,才会初始化数组,默认16。

sizeCtl= -2时,代表有1个线程在扩容。-1 已经代表初始化状态了,而且在扩容时,-2也有妙用!(-2有一个在扩容,-3有两个人在扩容)

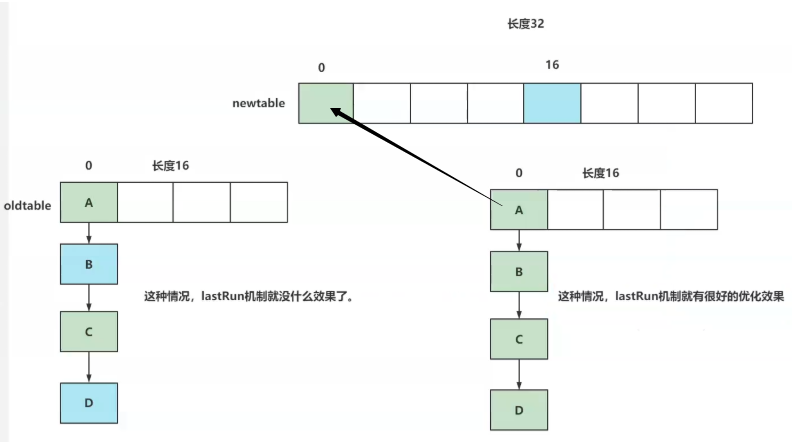

lastRun机制 ConcurrentHashMap当中在扩容操作时,涉及到oldTable中是一个链表。

需要将oldTable中链表的数据迁移到newTable中。

右侧的情况无法使用lastRun机制

左侧的情况就可以使用lastRun机制

在扩容时,当旧的数组要向新的数组迁移时,会对链表从后往前计算,若发现可以放到新数组的同一位置上,此时尾部位置的头结点,就直接放到指定的索引位置。

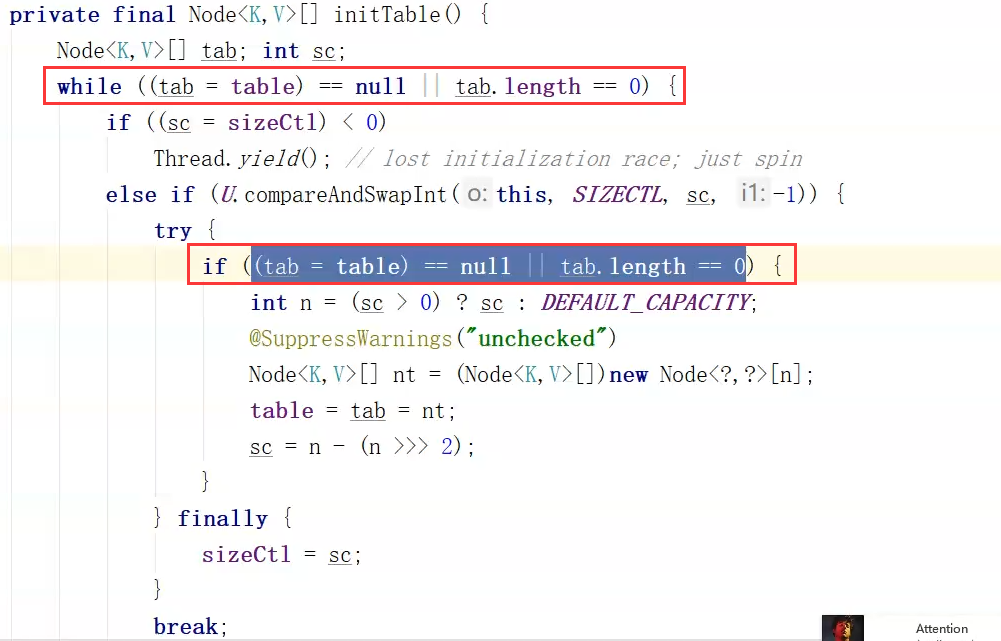

ConcurrenHashMap如何保证数组初始化线程安全? 基于DCL做的

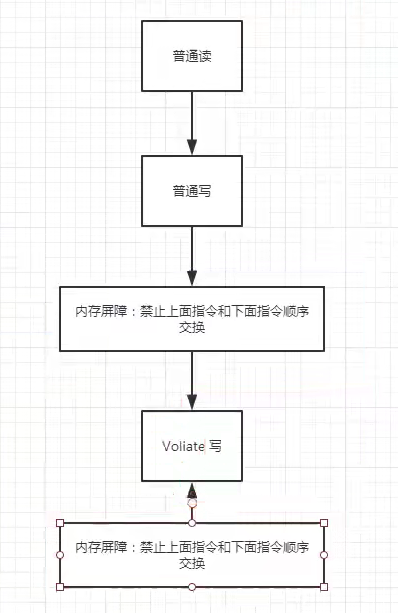

锁的实现是基于CAS的方式实现的

CHM在初始化数组时,sizeCtl=-1

要初始化数组的线程需要基于CAS成功的将sizeCtl改为-1

外层用while先判断一次是否初始化,基于cas加锁,内层再用if进行判断是否初始化

ConcurrenHashMap在并发扩容时,如何保证安全? 在计算Node中key的hash值时,会特意的将hash值正常情况的数值定义为正数

负数有特殊的含义,如果hash值为-1,代表当前节点正在扩容

最开始扩容A: 31~16

线程B插入数据,发现正在扩容,帮你迁移数据,15~0索引位置

每一个迁移完毕的数据,都会加上标识,代表扩容完毕,放上一-个ForwardingNode节点,代表扩容完毕,而且再扩容时,不会应用ConcurrentHashMap的遍历, 查询和添加(发现扩容,会帮忙~)

扩容流程 扩容条件

addCount方法中,如果元素个数到达扩容的阈值

链表达到8,但是数组长度没有到达64(链表转红黑树前)

在执行putAll操作时,如果传入的map.size大于当前map,需要扩容

transfer方法

扩容流程

扩容方式

多线程同时搬运数据

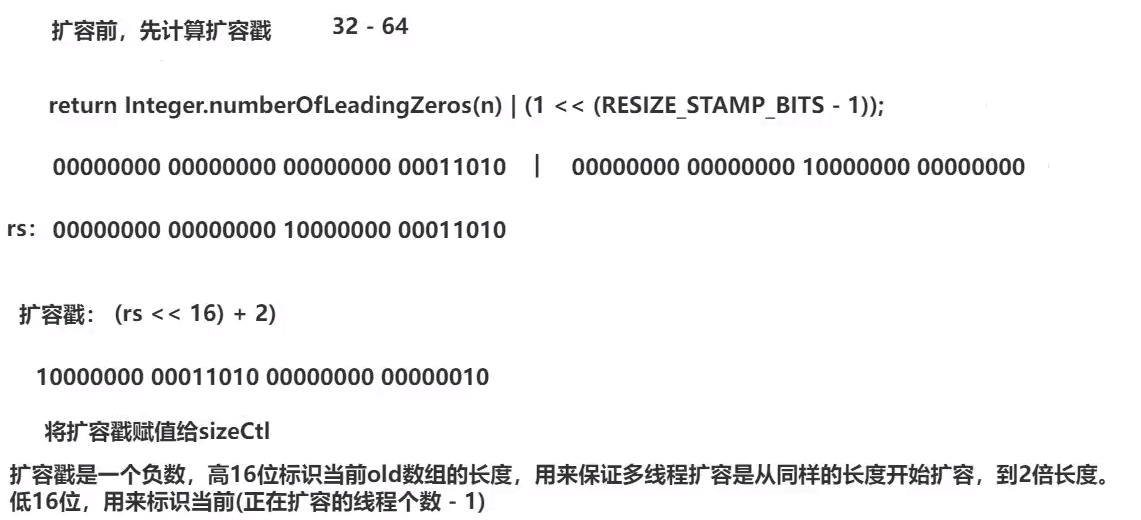

扩容戳

要在扩容时保证多个线程扩容的长度都是一样的

扩容步骤

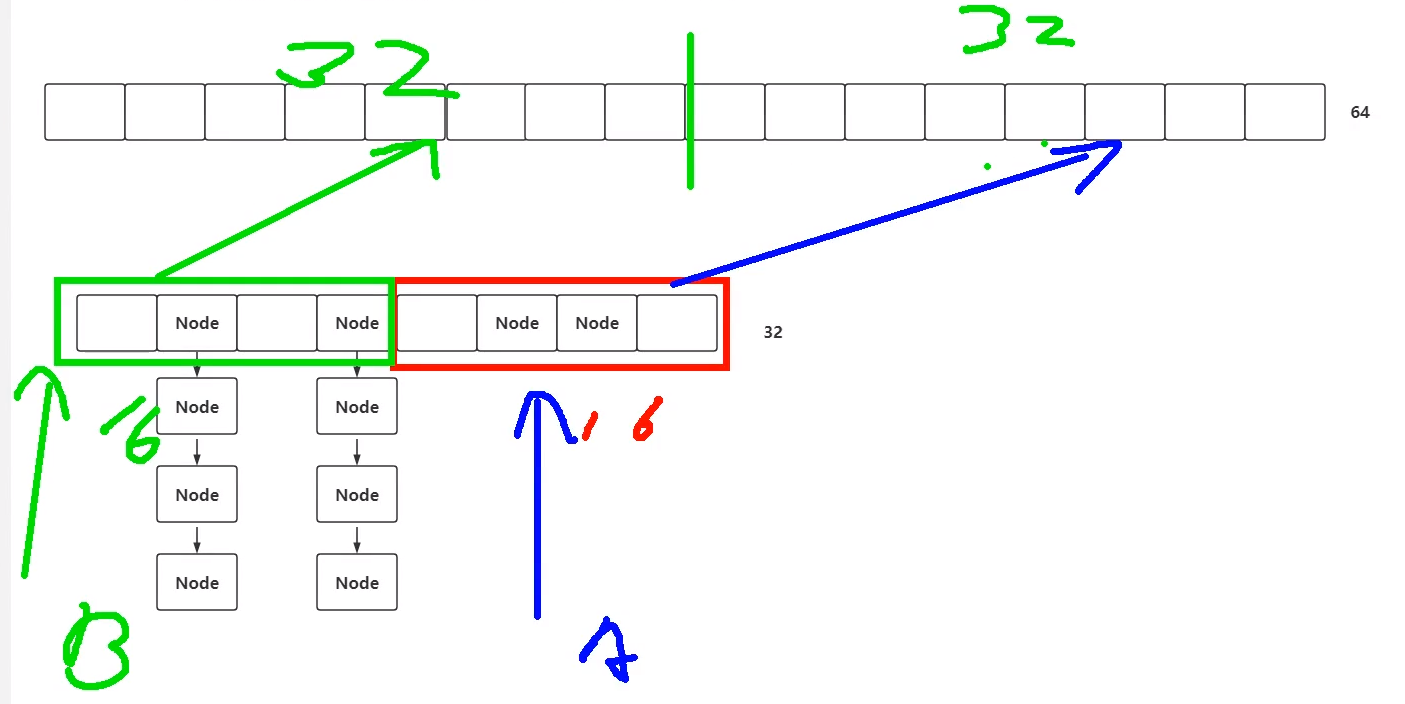

ConcurrentHashMap在扩容时,会先指定每个线程每次扩容的长度,最小值为16 (根据数组长度和CPU内核去指定每次扩容长度)。

开始扩容,而开始扩容的线程只有一个,第一个扩容的线程需要把新数组new出来。

有了新数组之后,其他线程再执行transfer方法(可能从helpTransfer方法进来),其他线程进来后,对扩容戳进行+ 1操作,也就是如果1个线程低位是-2,那么2个线程低位为-3

每次迁移时,会从后往前迁移数据,也就是说两个线程并发扩容:

线程A负责索引位置: 16~31

线程B负责索引位置: 15~0

是一个桶一个桶的去迁移数据,每次迁移完一个桶之后, 会将,会将ForwardingNode设置到老数组中

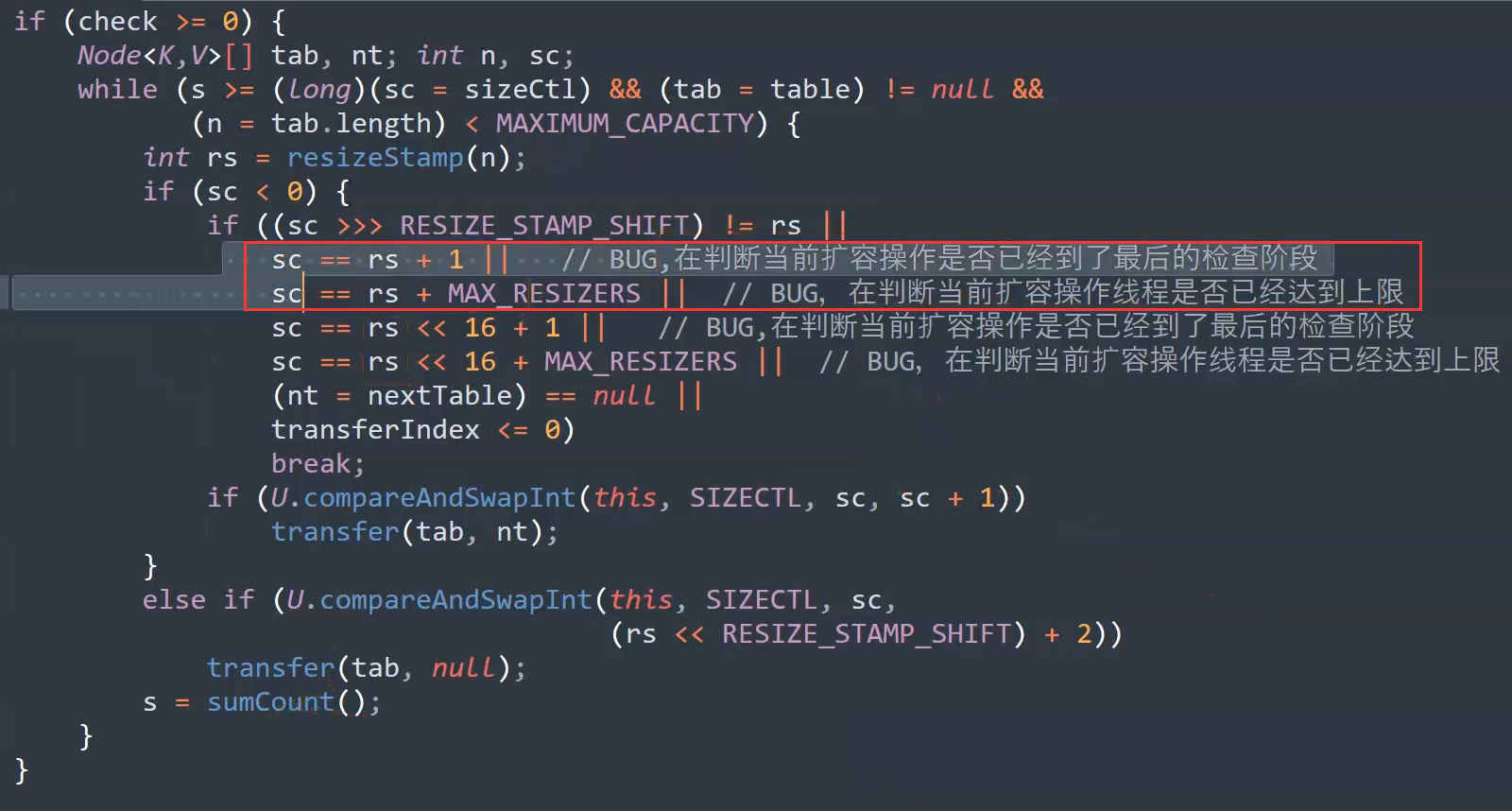

bug

协助扩容的条件判断

对正常操作,没有影响

rs是32位的,应该先左移16位,再+1

在jdk11修复了

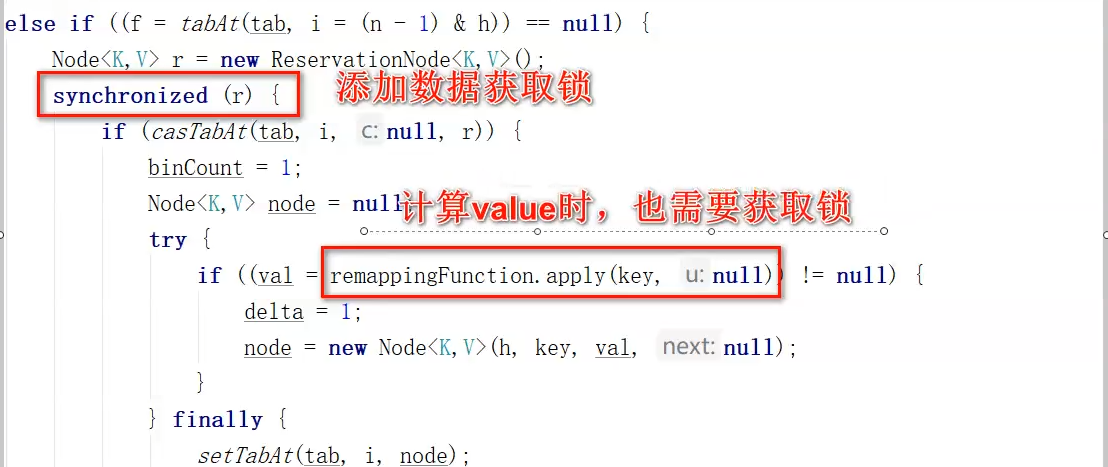

死锁问题

computeIfAbsent方法

编程中经常遇到这种数据结构,判断一个map中是否存在这个key,如果存在则处理value的数据,如果不存在,则创建一个满足value要求的数据结构放到value中。

使用:

hashMap.computeIfAbsent(“china”, key -> getValues(key)).add(“liSi”);

意思表示key为“China”的建值对是否存在,返回的是value的值。

如果存在则获取china的值,并操作值的set添加数据“lisi”。

如果不存在,则调用方法,新创建set结构,将”lisi”添加到set中,再存入到hashMap中。

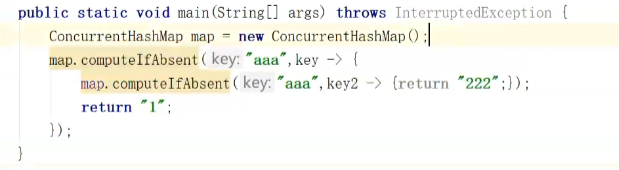

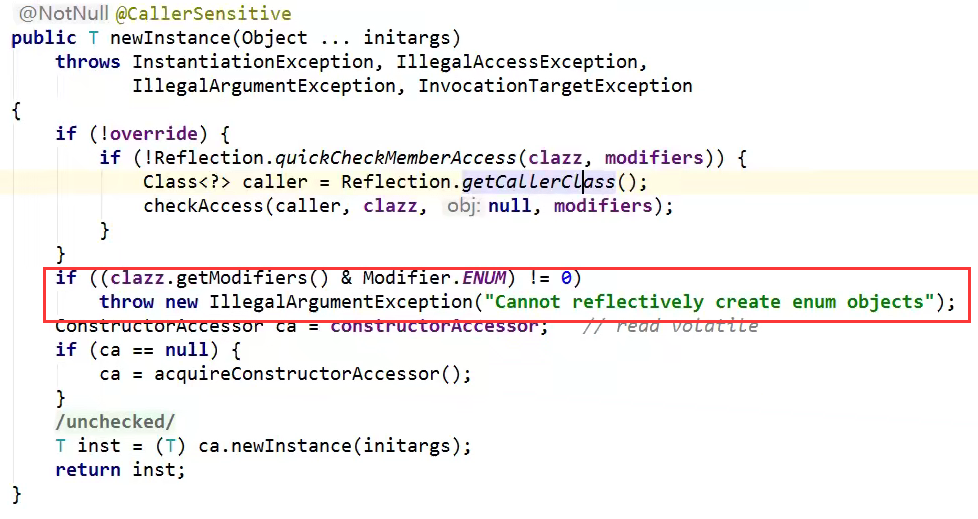

死锁问题

实例

原因:源码中有sync,线程A锁住了,第二次调用时线程B无法解锁。如果是同一个线程就可重入了。

解决发慢换发

使用时尽量避免

或者用put方法替代

小结 CopyOnWriteArrayList(Set/Map) 首先我们对 CopyOnWriteArraList 进行学习,其特点如下:

它相当于线程安全的ArrayList。和 ArrayList一样,它是个可变数组;但是和ArrayList 不同的时,它具有以下特性:

它最适合于具有以下特征的应用程序:List 大小通常保持很小,只读操作远多于可变操作,需要在遍历期间防止线程间的冲突。

它是线程安全的。

因为通常需要复制整个基础数组,所以可变操作(add()、set() 和remove() 等等)的开销很大。

迭代器支持 hasNext(), next()等不可变操作,但不支持可变 remove()等操作。

使用迭代器进行遍历的速度很快,并且不会与其他线程发生冲突。在构造迭代器时,迭代器依赖于不变的数组快照

+++

1. 独占锁效率低:采用读写分离思想解决

2. 写线程获取到锁,其他写线程阻塞

3. 复制思想: 当我们往一个容器添加元素的时候,不直接往当前容器添加,而是先将当前容器进行 Copy,复制出一个新的容器,然后新的容器里添加元素,添加完元素之后,再将原容器的引用指向新的容器。

这时候会抛出来一个新的问题,也就是数据不一致的问题。如果写线程还没来得及写会内存,其他的线程就会读到了脏数据。

==这就是 CopyOnWriteArrayList 的思想和原理。就是拷贝一份。 ==

+++

原因分析 (重点 ):动态数组与线程安全

下面从“动态数组”和“线程安全”两个方面进一步对CopyOnWriteArrayList 的原理进行说明。

“动态数组“机制

它内部有个“volatile 数组”(array)来保持数据。在“添加/修改/删除”数据时,都会新建一个数组,并将更新后的数据拷贝到新建的数组中,最后再将该数组赋值给“volatile 数组”, 这就是它叫做 CopyOnWriteArrayList 的原因

由于它在“添加/修改/删除”数据时,都会新建数组,所以涉及到修改数据的操作,CopyOnWriteArrayList 效率很低;但是单单只是进行遍历查找的话,效率比较高。

“线程安全”机制

通过 volatile 和互斥锁来实现的。

通过“volatile 数组”来保存数据的。一个线程读取 volatile 数组时,总能看到其它线程对该 volatile 变量最后的写入;就这样,通过 volatile 提供了“读取到的数据总是最新的”这个机制的保证。

通过互斥锁来保护数据。在“添加/修改/删除”数据时,会先“获取互斥锁”,再修改完毕之后,先将数据更新到“volatile 数组”中,然后再“释放互斥锁”,就达到了保护数据的目的。

总结 1.线程安全与线程不安全集合

集合类型中存在线程安全与线程不安全的两种,常见例如:

ArrayList —- Vector

HashMap —-HashTable

但是以上都是通过synchronized关键字实现效率较低

2.Collections构建的线程安全集合

3.java.util.concurrent并发包下

CopyOnWriteArrayList CopyOnWriteArraySet 类型,通过动态数组与线程安全各个方面保证线程安全。

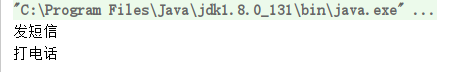

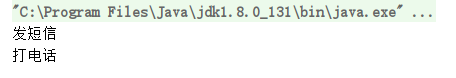

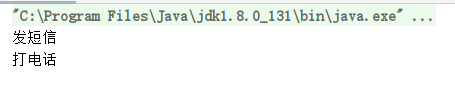

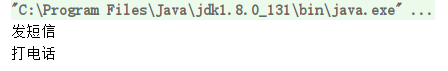

5、多线程锁 八锁现象 public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (()->{ phone.sendSms(); },"A" ).start(); new Thread (()->{ phone.call(); },"B" ).start(); } } class Phone { public synchronized void sendSms () { System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } }

一、二 正常执行,两个线程先打印,发短信还是打电话

public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (()->{ phone.sendSms(); },"A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (()->{ phone.call(); },"B" ).start(); } } class Phone { public synchronized void sendSms () { System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } }

运行结果:

发短信延时四秒

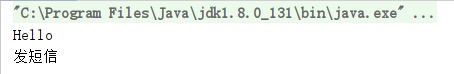

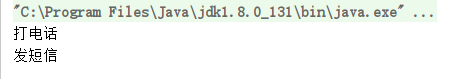

public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (()->{ phone.sendSms(); },"A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (()->{ phone.call(); },"B" ).start(); } } class Phone { public synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } }

运行结果:

原因

并不是顺序执行!是因为synchronized 锁的对象是方法的调用!对于两个方法用的是同一个锁,谁先拿到谁先执行!另外一个则等待!

三 如果我们添加一个普通方法,那么先执行哪一个呢?

public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (() -> { phone.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone.Hello(); }, "B" ).start(); } } class Phone { public synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } public void Hello () { System.out.println("Hello" ); } }

运行结果:

先执行hello,然后再执行发短信!

原因是hello是一个普通方法 ,不受synchronized锁的影响 。

但是我发现,如果我把发短信里面的延迟4秒去掉,那么就会顺序执行,先执行发短信然后再执行hello,原因应该是顺序执行的原因吧,不是太理解。

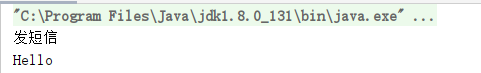

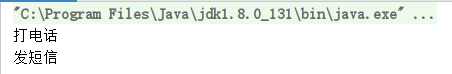

四 如果我们使用的是两个对象,一个调用发短信,一个调用打电话,那么整个顺序是怎么样的呢?

public class Test01 { public static void main (String[] args) { Phone phone1 = new Phone (); Phone phone2 = new Phone (); new Thread (() -> { phone1.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone2.call(); }, "B" ).start(); } } class Phone { public synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } public void Hello () { System.out.println("Hello" ); } }

运行结果

原因:在发短信方法中延迟了4s,又因为synchronized锁的是对象,但是我们这使用的是两个对象,所以每个对象都有一把锁,所以不会造成锁的等待。正常执行

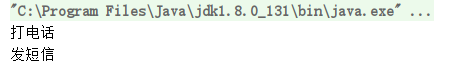

五、六 如果我们把synchronized的方法加上static变成静态方法!那么顺序又是怎么样的呢?

(1)我们先来使用一个对象调用两个方法!

public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (() -> { phone.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone.call(); }, "B" ).start(); } } class Phone { public static synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public static synchronized void call () { System.out.println("打电话" ); } }

运行结果

(2)如果我们使用两个对象调用两个方法!

public class Test01 { public static void main (String[] args) { Phone phone1 = new Phone (); Phone phone2 = new Phone (); new Thread (() -> { phone1.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone2.call(); }, "B" ).start(); } } class Phone { public static synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public static synchronized void call () { System.out.println("打电话" ); } }

运行结果

原因是什么呢? 为什么加了static就始终前面一个对象先执行呢!为什么后面会等待呢?

原因是:对于static静态方法来说,对于整个类Class来说只有一份,对于不同的对象使用的是同一份方法,相当于这个方法是属于这个类的,如果静态static方法使用synchronized锁定,那么这个synchronized锁会锁住整个对象!不管多少个对象,对于静态的锁都只有一把锁,谁先拿到这个锁就先执行,其他的进程都需要等待!

七 如果我们使用一个静态同步方法、一个同步方法、一个对象调用顺序是什么?

public class Test01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (() -> { phone.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone.call(); }, "B" ).start(); } } class Phone { public static synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } }

运行结果

因为一个锁的是Class类模板,一个锁的是对象调用者。后面那个打电话不需要等待发短信,直接运行就可以了。

八 如果我们使用一个静态同步方法、一个同步方法、两个对象调用顺序是什么呢?

public class Test01 { public static void main (String[] args) { Phone phone1 = new Phone (); Phone phone2 = new Phone (); new Thread (() -> { phone1.sendSms(); }, "A" ).start(); try { TimeUnit.SECONDS.sleep(1 ); } catch (InterruptedException e) { e.printStackTrace(); } new Thread (() -> { phone2.call(); }, "B" ).start(); } } class Phone { public static synchronized void sendSms () { try { TimeUnit.SECONDS.sleep(4 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("发短信" ); } public synchronized void call () { System.out.println("打电话" ); } }

运行结果

因为两个对象,一样的原因:两把锁锁的不是同一个东西,所以后面的第二个对象不需要等待第一个对象的执行。

小结 如何判断锁的是谁?锁到底锁的是谁?

锁会锁住:对象、类

new 出来的 this 是具体的一个对象

static Class 是唯一的一个模板

Synchronized实现同步的基础:java中的每一个对象都可以作为锁,具体表现为以下三种形式。

对于普通同步方法,锁是当前实例对象。

对于静态同步方法,锁是当前类的Class对象

对于同步方法块,锁是Synchronized括号里的配置的对象

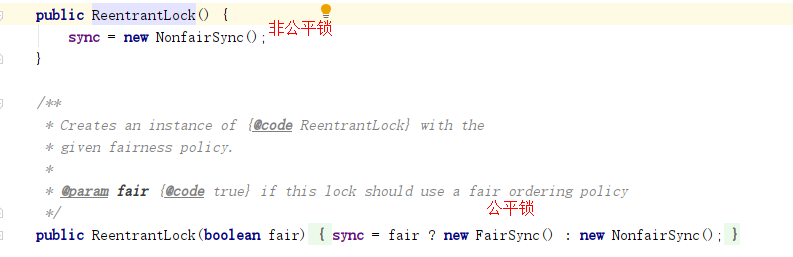

公平锁和非公平锁

公平锁: 非常公平;不能插队的,必须先来后到;

public ReentrantLock () { sync = new NonfairSync (); }

非公平锁: 非常不公平,允许插队的,可以改变顺序。**(默认为非公平锁)**

public ReentrantLock (boolean fair) { sync = fair ? new FairSync () : new NonfairSync (); }

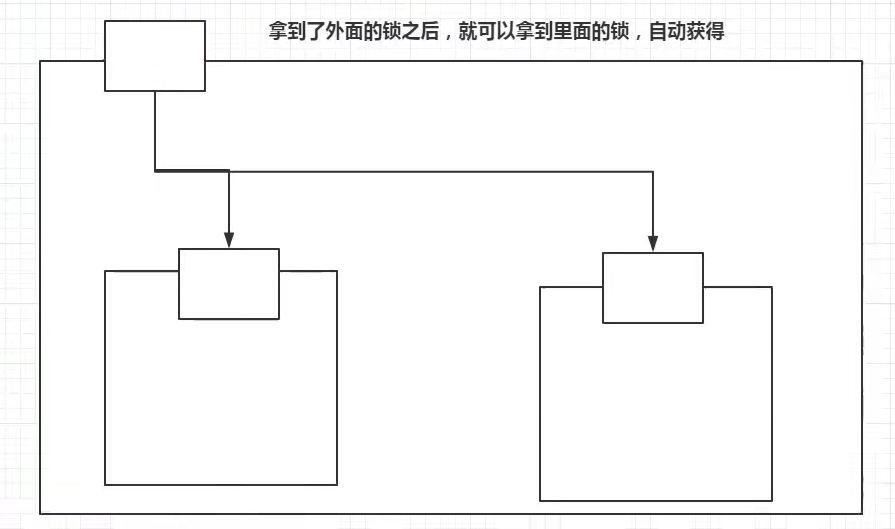

可重入锁(递归锁)

Synchronized锁

public class Demo01 { public static void main (String[] args) { Phone phone = new Phone (); new Thread (()->{ phone.sms(); },"A" ).start(); new Thread (()->{ phone.sms(); },"B" ).start(); } } class Phone { public synchronized void sms () { System.out.println(Thread.currentThread().getName()+"=> sms" ); call(); } public synchronized void call () { System.out.println(Thread.currentThread().getName()+"=> call" ); } }

lock锁

public class Demo02 { public static void main (String[] args) { Phone2 phone = new Phone2 (); new Thread (()->{ phone.sms(); },"A" ).start(); new Thread (()->{ phone.sms(); },"B" ).start(); } } class Phone2 { Lock lock=new ReentrantLock (); public void sms () { lock.lock(); try { System.out.println(Thread.currentThread().getName()+"=> sms" ); call(); } catch (Exception e) { e.printStackTrace(); }finally { lock.unlock(); } } public void call () { lock.lock(); try { System.out.println(Thread.currentThread().getName() + "=> call" ); }catch (Exception e){ e.printStackTrace(); } finally { lock.unlock(); } } }

lock锁必须配对,相当于lock和 unlock 必须数量相同;

在外面加的锁,也可以在里面解锁;在里面加的锁,在外面也可以解锁;

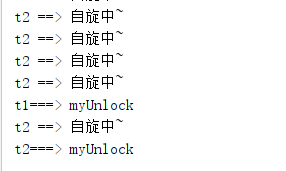

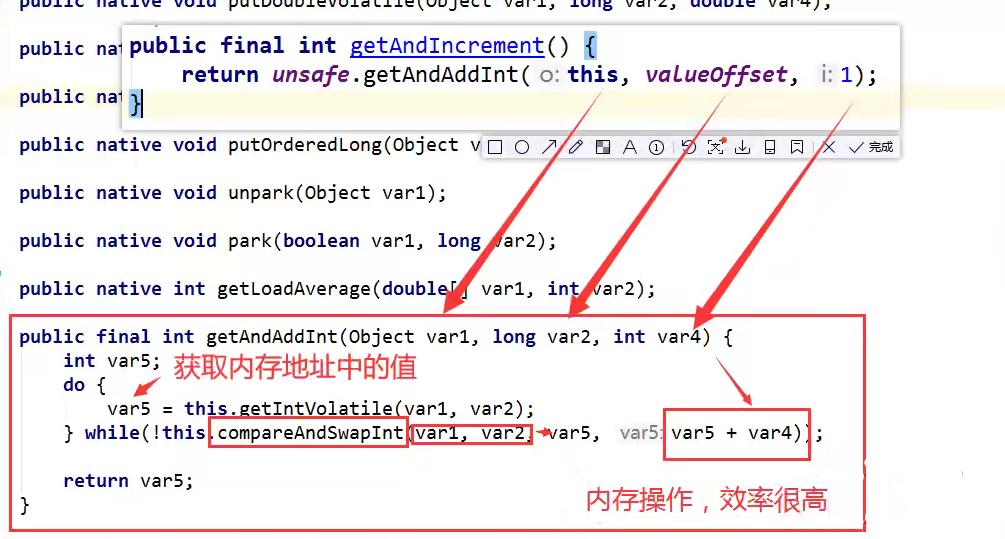

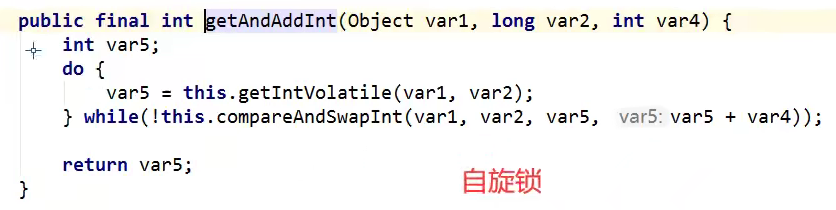

自旋锁 spinlock

public final int getAndAddInt (Object var1, long var2, int var4) { int var5; do { var5 = this .getIntVolatile(var1, var2); } while (!this .compareAndSwapInt(var1, var2, var5, var5 + var4)); return var5; }

自我设计自旋锁:

public class SpinlockDemo { AtomicReference<Thread> atomicReference=new AtomicReference <>(); public void myLock () { Thread thread = Thread.currentThread(); System.out.println(thread.getName()+"===> mylock" ); while (!atomicReference.compareAndSet(null ,thread)){ System.out.println(Thread.currentThread().getName()+" ==> 自旋中~" ); } } public void myunlock () { Thread thread=Thread.currentThread(); System.out.println(thread.getName()+"===> myUnlock" ); atomicReference.compareAndSet(thread,null ); } }

public class TestSpinLock { public static void main (String[] args) throws InterruptedException { ReentrantLock reentrantLock = new ReentrantLock (); reentrantLock.lock(); reentrantLock.unlock(); SpinlockDemo spinlockDemo=new SpinlockDemo (); new Thread (()->{ spinlockDemo.myLock(); try { TimeUnit.SECONDS.sleep(3 ); } catch (Exception e) { e.printStackTrace(); } finally { spinlockDemo.myunlock(); } },"t1" ).start(); TimeUnit.SECONDS.sleep(1 ); new Thread (()->{ spinlockDemo.myLock(); try { TimeUnit.SECONDS.sleep(3 ); } catch (Exception e) { e.printStackTrace(); } finally { spinlockDemo.myunlock(); } },"t2" ).start(); } }

运行结果

t1获得锁后,一直不解锁,t2进程必须等待t1进程Unlock后,才能Unlock,在这之前进行自旋等待。。。。

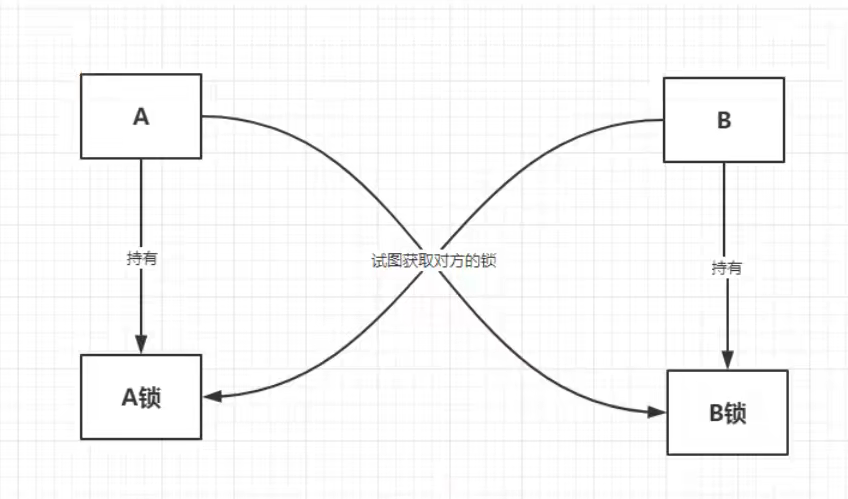

死锁排查 概述 死锁是什么?

死锁的产生:在资源有限的前提下,两个或者两个以上的线程相互占有对方的资源不释放,且相互不可剥夺,陷入循环等待的情景。

死锁条件:

互斥

请求和保持

不可抢占

等待循环

死锁原因:

系统资源不足

进程运行推进顺序不合适

资源分配不足

实例 import java.util.concurrent.TimeUnit;public class DeadLock { public static void main (String[] args) { String lockA= "lockA" ; String lockB= "lockB" ; new Thread (new MyThread (lockA,lockB),"t1" ).start(); new Thread (new MyThread (lockB,lockA),"t2" ).start(); } } class MyThread implements Runnable { private String lockA; private String lockB; public MyThread (String lockA, String lockB) { this .lockA = lockA; this .lockB = lockB; } @Override public void run () { synchronized (lockA){ System.out.println(Thread.currentThread().getName()+" lock" +lockA+"===>get" +lockB); try { TimeUnit.SECONDS.sleep(2 ); } catch (InterruptedException e) { e.printStackTrace(); } synchronized (lockB){ System.out.println(Thread.currentThread().getName()+" lock" +lockB+"===>get" +lockA); } } } }

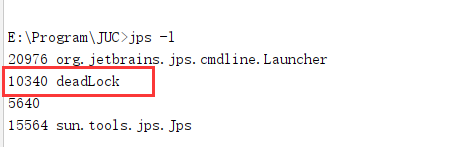

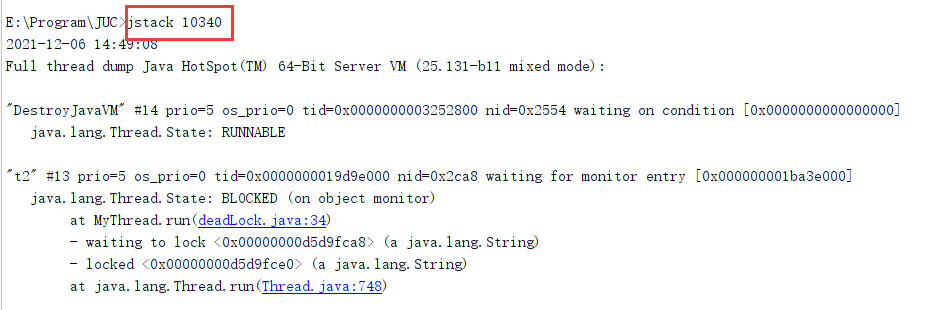

解决方法 1、使用jps定位进程号,jdk的bin目录下: 有一个jps

命令:jps -l(linux ps-ef)

2、使用jstack 进程进程号 找到死锁信息

一般情况信息在最后:

面试,工作中!排查问题!

1、日志

2、堆栈信息

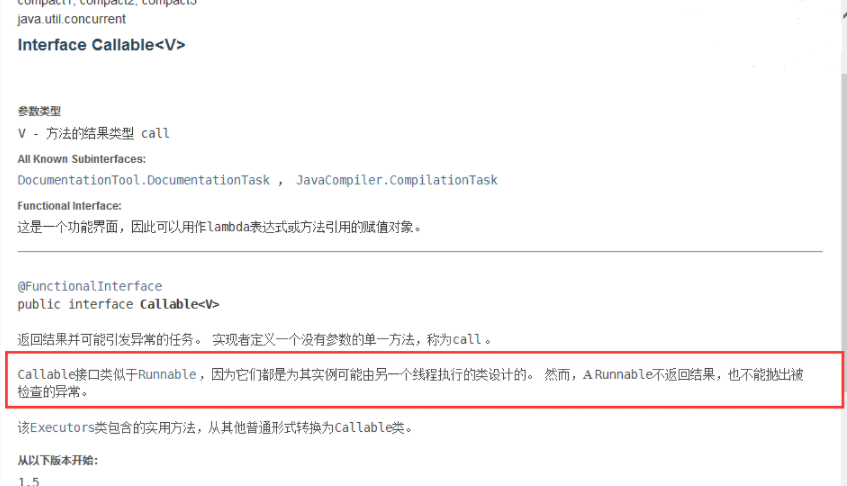

6、Callable 接口

1、可以有返回值;

2、可以抛出异常;

3、方法不同,run()/call()

创建线程的方法

runnable,执行run方法

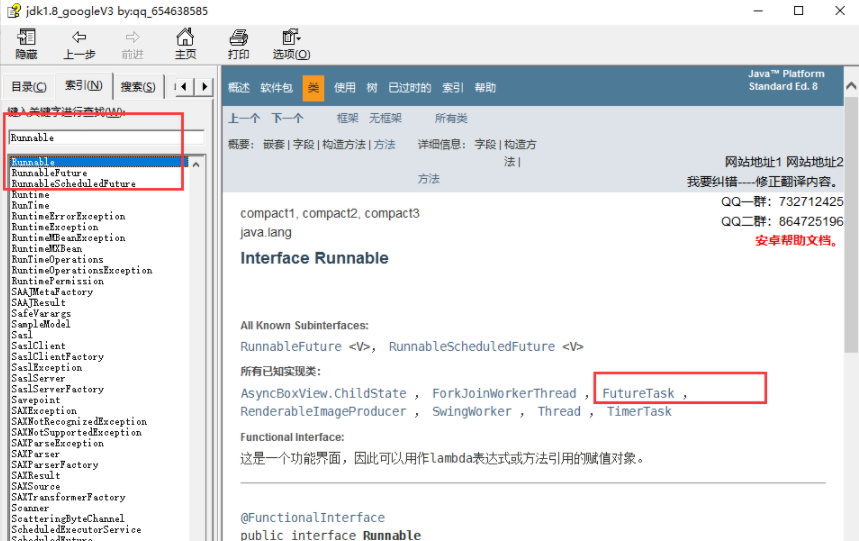

Runable接口又实现类FutureTask

FutureTask构造可以传递Classable

callable,执行call方法

thread,执行run方法,本质是runable的实现类

线程池

补充:如何将callable放到thread中?对于thread运行,他只能传入runable类型的参数,这是需要注意到runable中有一个futuretask的实现类,它里面是可以接受callable接口的。

代码测试 传统使用线程方式:

public class CallableTest { public static void main (String[] args) { for (int i = 1 ; i < 10 ; i++) { new Thread (new MyThread ()).start(); } } } class MyThread implements Runnable { @Override public void run () { System.out.println(Thread.currentThread().getName()); } }

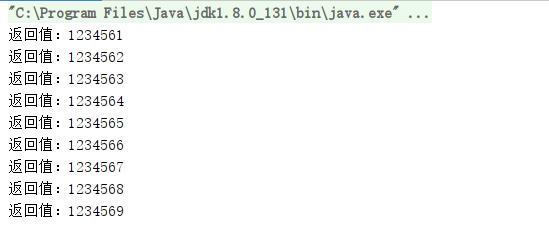

使用Callable进行多线程操作:

public class CallablrTest { public static void main (String[] args) throws ExecutionException, InterruptedException { for (int i = 1 ; i < 10 ; i++) { MyThread thread= new MyThread (); FutureTask<String> futureTask = new FutureTask <>(thread); new Thread (futureTask,String.valueOf(i)).start(); String s = futureTask.get(); System.out.println("返回值:" + s); } } } class MyThread implements Callable <String> { @Override public String call () { return "123456" +Thread.currentThread().getName(); } }

这样我们就可以使用Callable来进行多线程编程了,并且我们发现可以有返回值,并且可以抛出异常。

细节深挖 Runable接口又实现类FutureTask

FutureTask构造可以传递Classable

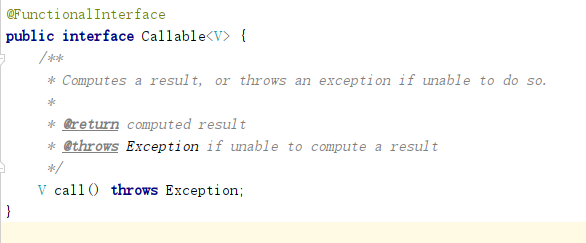

源码如下:

Calleable 泛型V就是call运行方法的返回值类型 ;

但是如何使用 呢?

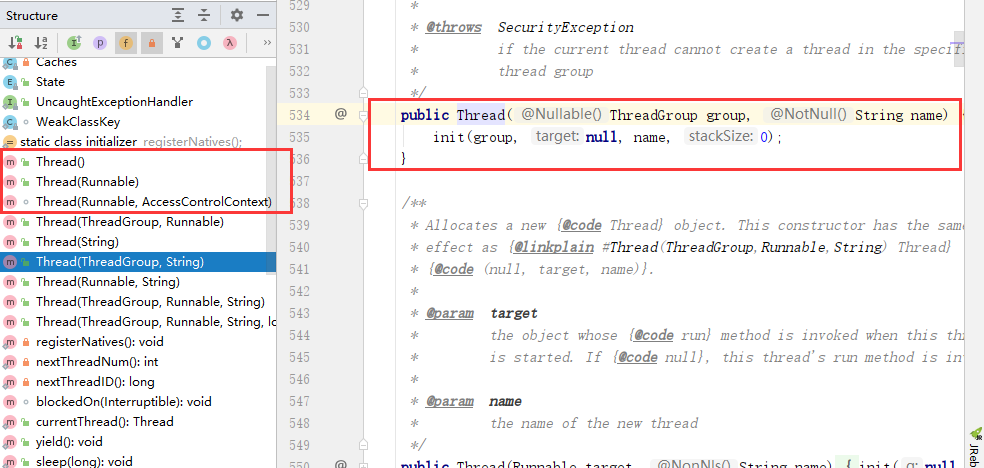

Callable怎么放入到Thread里面呢?

源码分析:

对于Thread运行,只能传入Runnable类型的参数;

我们这是Callable 怎么办呢?

看JDK api文档:

在Runnable里面有一个叫做FutureTask的实现类,我们进去看一下。

FutureTask中可以接受Callable参数;

这样我们就可以先把Callable 放入到FutureTask中, 再把FutureTask 放入到Thread就可以了。

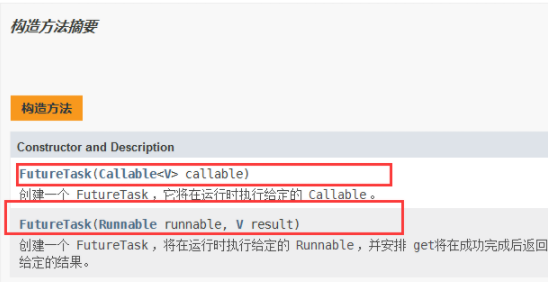

注意 public class CallablrTest { public static void main (String[] args) throws ExecutionException, InterruptedException { MyThread thread = new MyThread (); FutureTask<String> futureTask = new FutureTask <>(thread); new Thread (futureTask, "A" ).start(); new Thread (futureTask, "B" ).start(); String s = futureTask.get(); System.out.println("返回值:" + s); } } class MyThread implements Callable <String> { @Override public String call () { return "123456" + Thread.currentThread().getName(); } }

运行结果

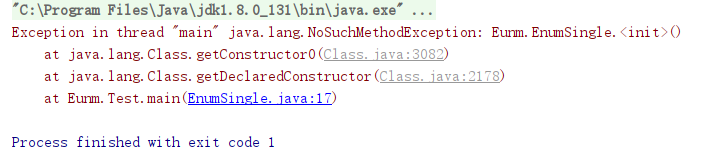

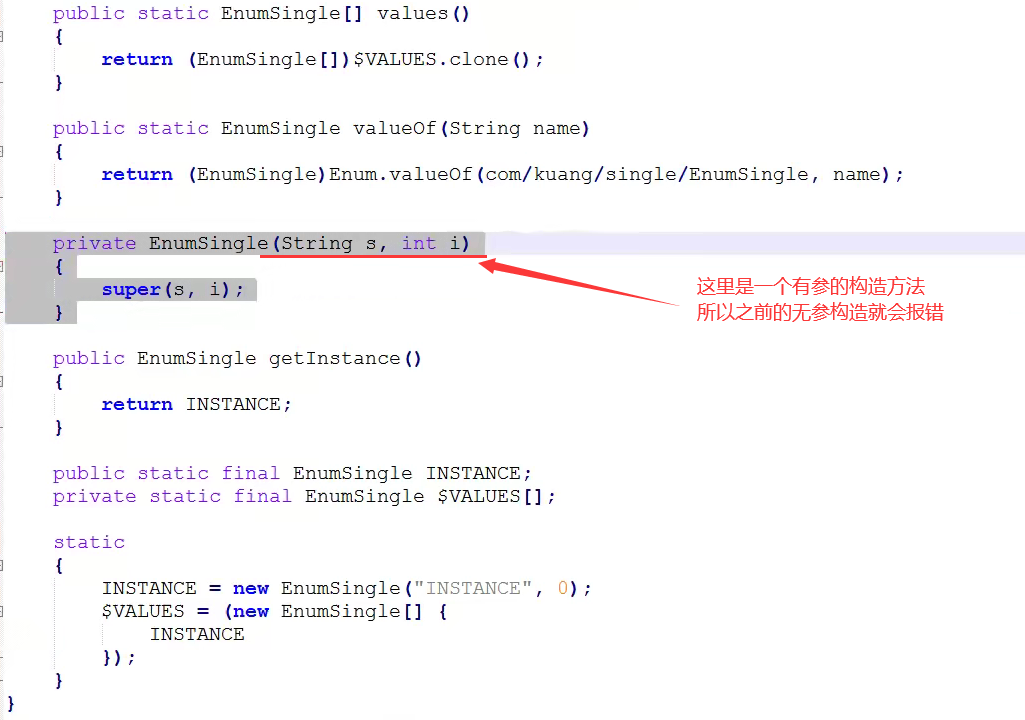

此处并不是缓存,是由于JVM第二次再调用FutrueTask对象所持有的线程,此时FutrueTask中一个呗vloatile修饰的state此时已经是非NEW状态了,则此时会直接结束对应的线程,就会导致任务也不执行。只是在第一次调用时返回结果并保存。

小结 在主线程中需要执行比较耗时的操作时,但又不想阻塞主线程时,可以把这些作业交给Future对象在后台完成当主线程将来需要时,就可以通过Future对象获得后台作业的计算结果或者执行状态。

一般FutureTask多用于耗时的计算,主线程可以在完成自己的任务后,再去获取结果。

仅在计算完成时才能检索结果;如果计算尚未完成,则阻塞get方法。一旦计算完成,就不能再重新开始或取消计算。get 方法而获取结果只有在计算完成时获取,否则会一直阻塞直到任务转入完成状态, 然后会返回结果或者抛出异常。

只计算一次。

7、JUC 三大辅助类 CountDownLatch (减少计数) 基础

CountDownLatch主要有两个方法,当一个或多个线程调用await方法时,这些线程会阻塞;

其它线程调用countDown方法会将计数器减1(调用countDown方法的线程不会阻塞);

当计数器的值变为0时,因await方法阻塞的线程会被唤醒,继续执行 。

其实就是一个减法计数器,对于计数器归零之后再进行后面的操作,这是一个计数器!

public class CountDownLatchDemo { public static void main (String[] args) throws InterruptedException { CountDownLatch countDownLatch = new CountDownLatch (6 ); for (int i = 1 ; i <= 6 ; i++) { new Thread (()->{ System.out.println(Thread.currentThread().getName()+" Go out" ); countDownLatch.countDown(); },String.valueOf(i)).start(); } countDownLatch.await(); System.out.println("close door" ); } }

主要方法:

countDown 减一操作;

await 等待计数器归零。

await等待计数器为0,就唤醒,再继续向下运行。

CountDownLatch 的原理是什么? CountDownLatch 是共享锁的一种实现,它默认构造 AQS 的 state 值为 count。当线程使用 countDown() 方法时,其实使用了tryReleaseShared方法以 CAS 的操作来减少 state,直至 state 为 0 。当调用 await() 方法的时候,如果 state 不为 0,那就证明任务还没有执行完毕,await() 方法就会一直阻塞,也就是说 await() 方法之后的语句不会被执行。然后,CountDownLatch 会自旋 CAS 判断 state == 0,如果 state == 0 的话,就会释放所有等待的线程,await() 方法之后的语句得到执行。

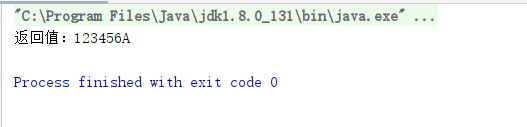

CyclicBarrier(循环栅栏) 基础 CyclicBarrier 和 CountDownLatch 非常类似,它也可以实现线程间的技术等待,但是它的功能比 CountDownLatch 更加复杂和强大。主要应用场景和 CountDownLatch 类似。

CountDownLatch 的实现是基于 AQS 的,而 CycliBarrier 是基于 ReentrantLock(ReentrantLock 也属于 AQS 同步器)和 Condition 的。

CyclicBarrier 的字面意思是可循环使用(Cyclic)的屏障(Barrier)。它要做的事情是:让一组线程到达一个屏障(也可以叫同步点)时被阻塞,直到最后一个线程到达屏障时,屏障才会开门,所有被屏障拦截的线程才会继续干活。

CyclicBarrier看英文单词可以看出大概就是循环阻塞的意思,在使用中CyclicBarrier的构造方法第一个参数是目标障碍数,每次执行CyclicBarrier一次障碍数会加一,如果达到了目标障碍数,才会执行cyclicBarrier.await (之后的语句。可以将CyclicBarrier理解为加1操作。

其实就是一个加法计数器;

public class CyclicBarrierDemo { public static void main (String[] args) { CyclicBarrier cyclicBarrier = new CyclicBarrier (7 ,()->{ System.out.println("召唤神龙~" ); }); for (int i = 1 ; i <= 7 ; i++) { int finalI = i; new Thread (()->{ System.out.println(Thread.currentThread().getName()+" 收集了第 {" + finalI+"} 颗龙珠" ); try { cyclicBarrier.await(); } catch (InterruptedException e) { e.printStackTrace(); } catch (BrokenBarrierException e) { e.printStackTrace(); } }).start(); } } }

CyclicBarrier 的原理是什么? CyclicBarrier 内部通过一个 count 变量作为计数器,count 的初始值为 parties 属性的初始化值,每当一个线程到了栅栏这里了,那么就将计数器减 1。如果 count 值为 0 了,表示这是这一代最后一个线程到达栅栏,就尝试执行我们构造方法中输入的任务。

private final int parties;private int count;

下面我们结合源码来简单看看。

1、CyclicBarrier 默认的构造方法是 CyclicBarrier(int parties),其参数表示屏障拦截的线程数量,每个线程调用 await() 方法告诉 CyclicBarrier 我已经到达了屏障,然后当前线程被阻塞。

public CyclicBarrier (int parties) { this (parties, null ); } public CyclicBarrier (int parties, Runnable barrierAction) { if (parties <= 0 ) throw new IllegalArgumentException (); this .parties = parties; this .count = parties; this .barrierCommand = barrierAction; }

其中,parties 就代表了有拦截的线程的数量,当拦截的线程数量达到这个值的时候就打开栅栏,让所有线程通过。

2、当调用 CyclicBarrier 对象调用 await() 方法时,实际上调用的是 dowait(false, 0L)方法。 await() 方法就像树立起一个栅栏的行为一样,将线程挡住了,当拦住的线程数量达到 parties 的值时,栅栏才会打开,线程才得以通过执行。

public int await () throws InterruptedException, BrokenBarrierException { try { return dowait(false , 0L ); } catch (TimeoutException toe) { throw new Error (toe); } }

dowait(false, 0L)方法源码分析如下:

private int count;private int dowait (boolean timed, long nanos) throws InterruptedException, BrokenBarrierException, TimeoutException { final ReentrantLock lock = this .lock; lock.lock(); try { final Generation g = generation; if (g.broken) throw new BrokenBarrierException (); if (Thread.interrupted()) { breakBarrier(); throw new InterruptedException (); } int index = --count; if (index == 0 ) { boolean ranAction = false ; try { final Runnable command = barrierCommand; if (command != null ) command.run(); ranAction = true ; nextGeneration(); return 0 ; } finally { if (!ranAction) breakBarrier(); } } for (;;) { try { if (!timed) trip.await(); else if (nanos > 0L ) nanos = trip.awaitNanos(nanos); } catch (InterruptedException ie) { if (g == generation && ! g.broken) { breakBarrier(); throw ie; } else { Thread.currentThread().interrupt(); } } if (g.broken) throw new BrokenBarrierException (); if (g != generation) return index; if (timed && nanos <= 0L ) { breakBarrier(); throw new TimeoutException (); } } } finally { lock.unlock(); } }

Semaphore(信号灯) 基础 sync和lock一次只允许一个线程访问某个资源,而semaphore一次可以同时控制特定资源的线程数量。

Semaphore的构造方法中传入的第一个参数是最大信号量(可以看成最大线程池),每个信号量初始化为一个最多只能分发一个许可证。使用acquire方法获得许可证,release 方法释放许可。

抢车位:

3个车位 6辆车:

public class SemaphoreDemo { public static void main (String[] args) { Semaphore semaphore = new Semaphore (3 ); for (int i = 1 ; i <= 6 ; i++) { int finalI = i; new Thread (()->{ try { semaphore.acquire(); System.out.println(Thread.currentThread().getName()+" 抢到了车位{" + finalI +"}" ); TimeUnit.SECONDS.sleep(2 ); System.out.println(Thread.currentThread().getName()+" 离开车位" ); } catch (InterruptedException e) { e.printStackTrace(); }finally { semaphore.release(); } },String.valueOf(i)).start(); } } }

原理:

semaphore.acquire()获得资源,如果资源已经使用完了,就等待资源释放后再进行使用!

semaphore.release()释放,会将当前的信号量释放+1,然后唤醒等待的线程!

作用: 多个共享资源互斥的使用! 并发限流,控制最大的线程数!

两种模式

公平模式: 调用 acquire() 方法的顺序就是获取许可证的顺序,遵循 FIFO;非公平模式: 抢占式的。

Semaphore 对应的两个构造方法如下:

public Semaphore (int permits ) { sync = new NonfairSync (permits ); } public Semaphore (int permits , boolean fair) { sync = fair ? new FairSync (permits ) : new NonfairSync (permits ); }

这两个构造方法,都必须提供许可的数量,第二个构造方法可以指定是公平模式还是非公平模式,默认非公平模式。

Semaphore 通常用于那些资源有明确访问数量限制的场景比如限流(仅限于单机模式,实际项目中推荐使用 Redis +Lua 来做限流)。

Semaphore 的原理是什么? Semaphore 是共享锁的一种实现,它默认构造 AQS 的 state 值为 permits,你可以将 permits 的值理解为许可证的数量,只有拿到许可证的线程才能执行。

调用semaphore.acquire() ,线程尝试获取许可证,如果 state >= 0 的话,则表示可以获取成功。如果获取成功的话,使用 CAS 操作去修改 state 的值 state=state-1。如果 state<0 的话,则表示许可证数量不足。此时会创建一个 Node 节点加入阻塞队列,挂起当前线程。

public void acquire () throws InterruptedException { sync.acquireSharedInterruptibly(1 ); } public final void acquireSharedInterruptibly (int arg) throws InterruptedException { if (Thread.interrupted()) throw new InterruptedException (); if (tryAcquireShared(arg) < 0 ) doAcquireSharedInterruptibly(arg); }

调用semaphore.release(); ,线程尝试释放许可证,并使用 CAS 操作去修改 state 的值 state=state+1。释放许可证成功之后,同时会唤醒同步队列中的一个线程。被唤醒的线程会重新尝试去修改 state 的值 state=state-1 ,如果 state>=0 则获取令牌成功,否则重新进入阻塞队列,挂起线程。

public void release () { sync.releaseShared(1 ); } public final boolean releaseShared (int arg) { if (tryReleaseShared(arg)) { doReleaseShared(); return true ; } return false ; }

Exchange(交换者) Exchanger可以用于线程间交换信息。它提供一个同步点,当两个线程都到达这个同步点时,它们的信息交换。这两个线程通过exchange方法交换数据,如果第一个线程先执行exchange()方法,它会一直等待第二个线程也执行exchange方法,当两个线程都到达同步点时,这两个线程就可以交换数据,将本线程生产出来的数据传递给对方。

下面来看一下Exchanger的应用场景:

Exchanger可以用于遗传算法,遗传算法里需要选出两个人作为交配对象,这时候会交换两人的数据,并使用交叉规则得出2个交配结果。

Exchanger也可以用于校对工作,比如我们需要将纸制银行流水通过人工的方式录入成电子银行流水,为了避免错误,采用AB岗两人进行录入,录入到Excel之后,系统需要加载这两个Excel,并对两个Excel数据进行校对,看看是否录入一致。

public class ExchangerDemo { private static final Exchanger<String> exgr = new Exchanger <String>(); private static ExecutorService threadPool = Executors.newFixedThreadPool(2 ); public static void main (String[] args) { threadPool.execute(new Runnable () { @Override public void run () { try { String A = "银行流水100" ; String B=exgr.exchange(A); System.out.println("A的视角:A和B数据是否一致:" + A.equals(B) + ",A录入的是:" + A + ",B录入是:" + B); } catch (InterruptedException e) { } } }); threadPool.execute(new Runnable () { @Override public void run () { try { String B = "银行流水200" ; String A = exgr.exchange(B); System.out.println("B的视角:A和B数据是否一致:" + A.equals(B) + ",A录入的是:" + A + ",B录入是:" + B); } catch (InterruptedException e) { } } }); threadPool.shutdown(); } }

如果两个线程有一个没有执行exchange()方法,则会一直等待,如果担心有特殊情况发生,避免一直等待,可以使用exchange(V x,longtimeout,TimeUnit unit)设置最大等待时长。

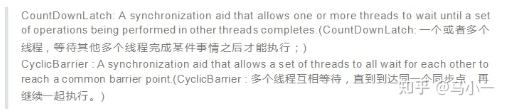

CyclicBarrier 和 CountDownLatch 的区别 CountDownLatch 是计数器,只能使用一次,而 CyclicBarrier 的计数器提供 reset 功能,可以多次使用。但是我不那么认为它们之间的区别仅仅就是这么简单的一点。我们来从 jdk 作者设计的目的来看,javadoc 是这么描述它们的:

对于 CountDownLatch 来说,重点是“一个线程(多个线程)等待”,而其他的 N 个线程在完成“某件事情”之后,可以终止,也可以等待。而对于 CyclicBarrier,重点是多个线程,在任意一个线程没有完成,所有的线程都必须等待。

CountDownLatch 是计数器,线程完成一个记录一个,只不过计数不是递增而是递减,而

CyclicBarrier 更像是一个阀门,需要所有线程都到达,阀门才能打开,然后继续执行。

8、读写锁 悲观锁和乐观锁 悲观锁 概述

优点:能解决并发中的各种问题

缺点:不支持并发操作

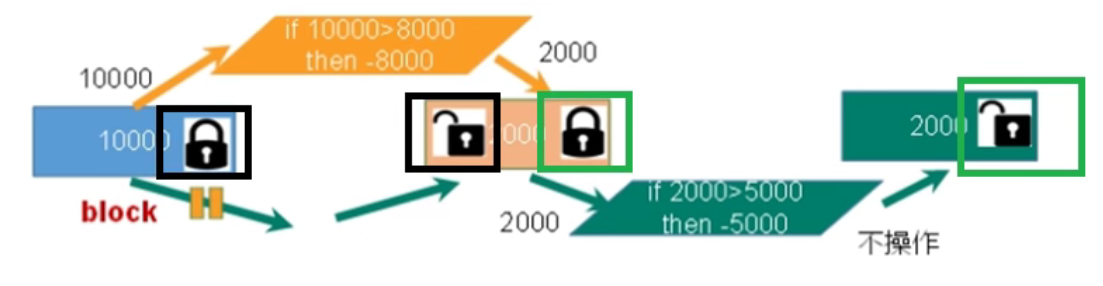

之所以叫做悲观锁,是因为这是一种对数据的修改持有悲观态度的并发控制方式。总是假设最坏的情况,每次读取数据的时候都默认其他线程会更改数据,因此需要进行加锁操作,当其他线程想要访问数据时,都需要阻塞挂起。悲观锁的实现:

传统的关系型数据库使用这种锁机制,比如行锁、表锁、读锁、写锁等,都是在操作之前先上锁。

Java 里面的同步 synchronized 关键字的实现。

分类

悲观锁主要分为共享锁和排他锁:

共享锁【shared locks】又称为读锁,简称 S 锁。顾名思义,共享锁就是多个事务对于同一数据可以共享一把锁,都能访问到数据,但是只能读不能修改。

排他锁【exclusive locks】又称为写锁,简称 X 锁。顾名思义,排他锁就是不能与其他锁并存,如果一个事务获取了一个数据行的排他锁,其他事务就不能再获取该行的其他锁,包括共享锁和排他锁。获取排他锁的事务可以对数据行读取和修改。

说明

悲观并发控制实际上是“先取锁再访问”的保守策略,为数据处理的安全提供了保证。但是在效率方面,处理加锁的机制会让数据库产生额外的开销,还有增加产生死锁的机会。另外还会降低并行性,一个事务如果锁定了某行数据,其他事务就必须等待该事务处理完才可以处理那行数据。

乐观锁

概述

特点:支持并发

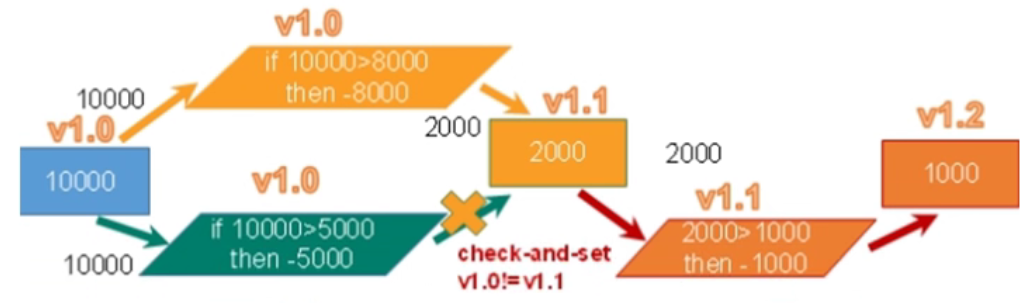

乐观锁采取了更加宽松的加锁机制。也是为了避免数据库幻读、业务处理时间过长等原因引起数据处理错误的一种机制,但乐观锁不会刻意使用数据库本身的锁机制,而是依据数据本身来保证数据的正确性。乐观锁的实现:

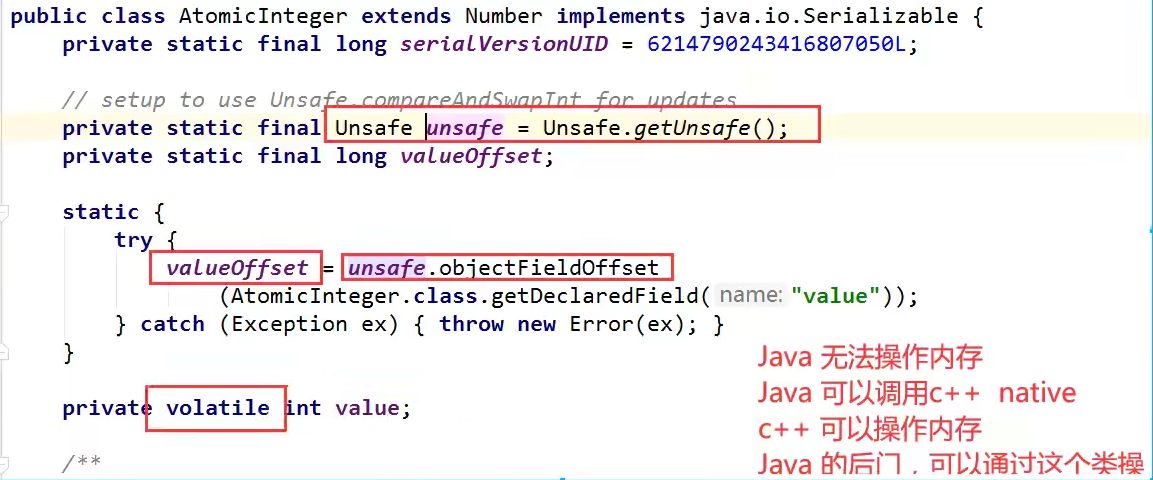

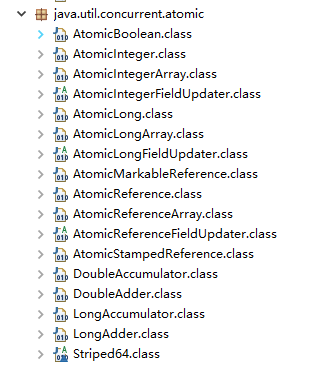

CAS 实现:Java 中java.util.concurrent.atomic包下面的原子变量使用了乐观锁的一种 CAS 实现方式。

版本号控制:一般是在数据表中加上一个数据版本号 version 字段,表示数据被修改的次数。当数据被修改时,version 值会 +1。当线程 A 要更新数据时,在读取数据的同时也会读取 version 值,在提交更新时,若刚才读取到的 version 值与当前数据库中的 version 值相等时才更新,否则重试更新操作,直到更新成功。

说明

乐观并发控制相信事务之间的数据竞争(data race)的概率是比较小的,因此尽可能直接做下去,直到提交的时候才去锁定,所以不会产生任何锁和死锁。

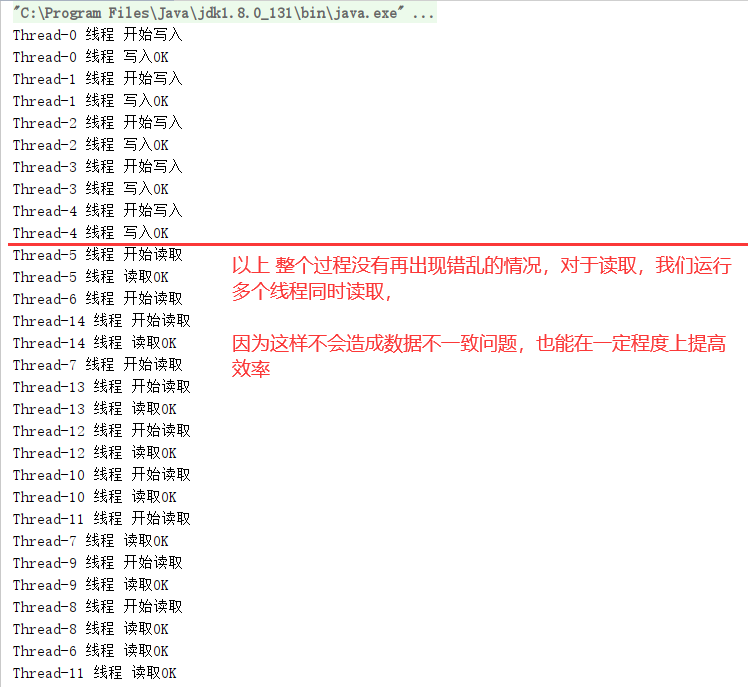

实例 如果我们做一个我们自己的cache缓存。分别有写入操作、读取操作;

我们采用五个线程去写入,使用十个线程去读取。

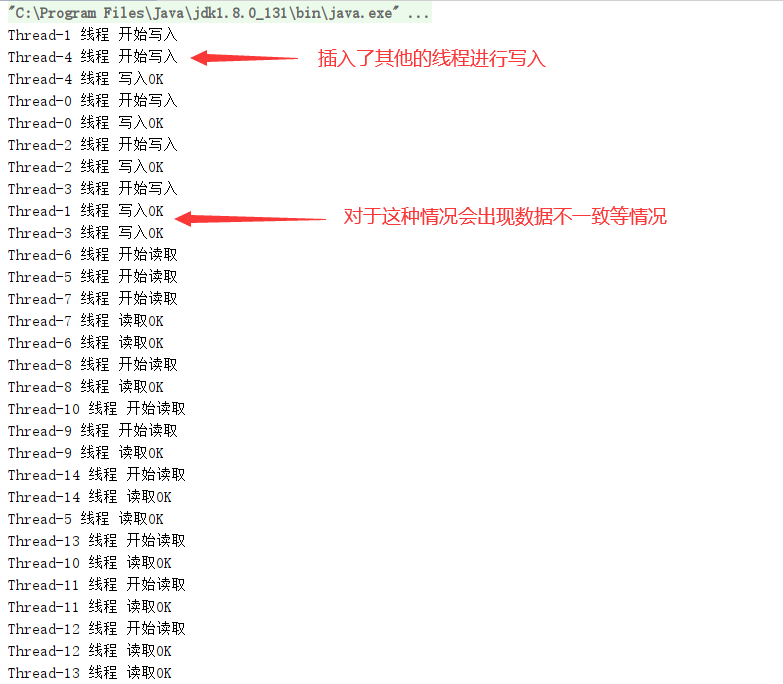

不加锁实现 我们来看一下这个的效果,如果我们不加锁的情况!

import java.util.HashMap;import java.util.Map;import java.util.concurrent.locks.Lock;import java.util.concurrent.locks.ReadWriteLock;import java.util.concurrent.locks.ReentrantLock;import java.util.concurrent.locks.ReentrantReadWriteLock;public class ReadWriteLockDemo { public static void main (String[] args) { MyCache_ReadWriteLock mycache = new MyCache_ReadWriteLock (); for (int i = 1 ; i <=5 ; i++) { int finalI = i; new Thread (()->{ mycache.put(String.valueOf(finalI),String.valueOf(finalI)); }).start(); } for (int i = 1 ; i <=10 ; i++) { int finalI = i; new Thread (()->{ String o = mycache.get(String.valueOf(finalI)); }).start(); } } } class MyCache_ReadWriteLock { private volatile Map<String,String> map=new HashMap <>(); private ReadWriteLock readWriteLock=new ReentrantReadWriteLock (); private Lock lock=new ReentrantLock (); public void put (String key,String value) { System.out.println(Thread.currentThread().getName()+" 线程 开始写入" ); map.put(key, value); System.out.println(Thread.currentThread().getName()+" 线程 写入OK" ); } public String get (String key) { System.out.println(Thread.currentThread().getName()+" 线程 开始读取" ); String o = map.get(key); System.out.println(Thread.currentThread().getName()+" 线程 读取OK" ); return o; } }

运行结果

由此可见,我们不加锁的情况,多线程的读写会造成数据不可靠的问题。

我们也可以采用synchronized 这种重量锁和轻量锁 lock 去保证数据的可靠。

读写锁实现 但是这次我们采用更细粒度的锁:ReadWriteLock 读写锁来保证

import java.util.HashMap;import java.util.Map;import java.util.concurrent.locks.Lock;import java.util.concurrent.locks.ReadWriteLock;import java.util.concurrent.locks.ReentrantLock;import java.util.concurrent.locks.ReentrantReadWriteLock;public class ReadWriteLockDemo { public static void main (String[] args) { MyCache_ReadWriteLock mycache = new MyCache_ReadWriteLock (); for (int i = 1 ; i <=5 ; i++) { int finalI = i; new Thread (()->{ mycache.put(String.valueOf(finalI),String.valueOf(finalI)); }).start(); } for (int i = 1 ; i <=10 ; i++) { int finalI = i; new Thread (()->{ String o = mycache.get(String.valueOf(finalI)); }).start(); } } } class MyCache_ReadWriteLock { private volatile Map<String,String> map=new HashMap <>(); private ReadWriteLock readWriteLock=new ReentrantReadWriteLock (); private Lock lock=new ReentrantLock (); public void put (String key,String value) { readWriteLock.writeLock().lock(); try { System.out.println(Thread.currentThread().getName()+" 线程 开始写入" ); map.put(key, value); System.out.println(Thread.currentThread().getName()+" 线程 写入OK" ); } catch (Exception e) { e.printStackTrace(); } finally { readWriteLock.writeLock().unlock(); } } public String get (String key) { String o="" ; readWriteLock.readLock().lock(); try { System.out.println(Thread.currentThread().getName()+" 线程 开始读取" ); o = map.get(key); System.out.println(Thread.currentThread().getName()+" 线程 读取OK" ); } catch (Exception e) { e.printStackTrace(); } finally { readWriteLock.readLock().unlock(); } return o; } }

运行结果

读写锁的演变 读写锁:一个资源可以被多个读线程访问,或者可以被一个写线程访问,但是不能同时存在读写线程,读写互斥,读读共享的。

无锁

添加锁

使用Synchronized和Reentrantlock都是独占的,每次只能来一个操作

读写锁

读读可以共享,提升性能,同时可以多人进行读操作

缺点

造成锁饥饿,一直读,没有写操作,比如坐地铁

读时候,不能写,只能读。完成之后,才可以写,写操作可以读

读写锁的降级 将写入锁降级为读锁

9、阻塞队列 阻塞队列,顾名思义,首先它是一个队列,通过一个共享的队列,可以使得数据由队列的一端输入,从另外一端输出;

当队列是空的,从队列中获取元素的操作将会被阻塞

当队列是满的,从队列中添加元素的操作将会被阻塞

试图从空的队列中获取元素的线程将会被阻塞,直到其他线程往空的队列插入新的元素

试图向已满的队列中添加新元素的线程将会被阻塞,直到其他线程从队列中移除一个或多个元素或者完全清空,使队列变得空闲起来并后续新增

在多线程领域:所谓阻塞,在某些情况下会挂起线程(即阻塞),一旦条件满足,被挂起的线程又会自动被唤起

为什么需要 BlockingQueue

好处是我们不需要关心什么时候需要阻塞线程,什么时候需要唤醒线程,因为这一切BlockingQueue 都给你一手包办了。

多线程环境中,通过队列可以很容易实现数据共享,比如经典的“生产者”和 “消费者”模型中,通过队列可以很便利地实现两者之间的数据共享。

当队列中没有数据的情况下,消费者端的所有线程都会被自动阻塞(挂起),直到有数据放入队列

当队列中填满数据的情况下,生产者端的所有线程都会被自动阻塞(挂起),直到队列中有空的位置,线程被自动唤醒

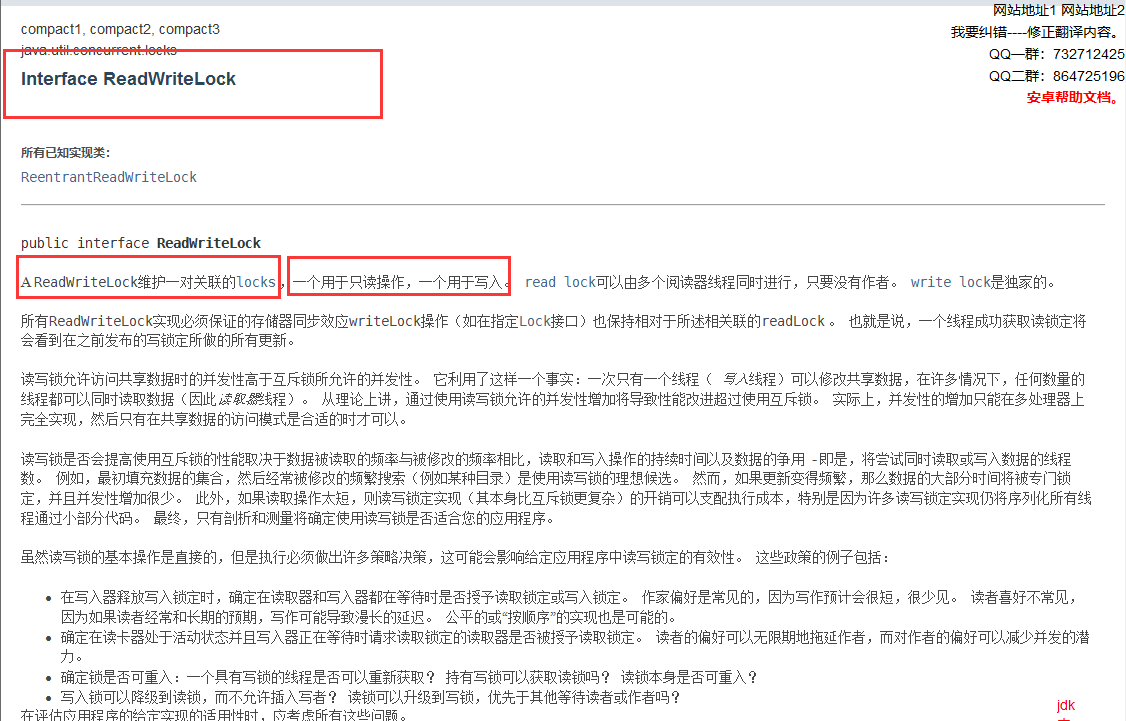

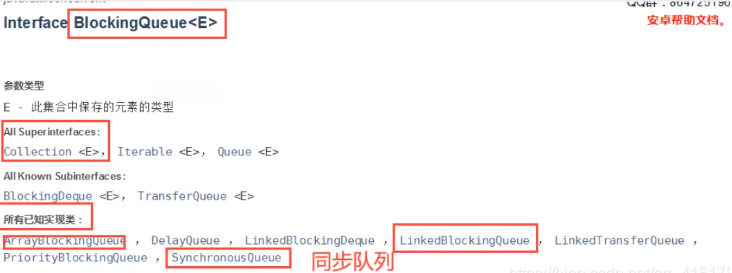

BlockingQueue 概述 阻塞队列jdk1.8文档解释:

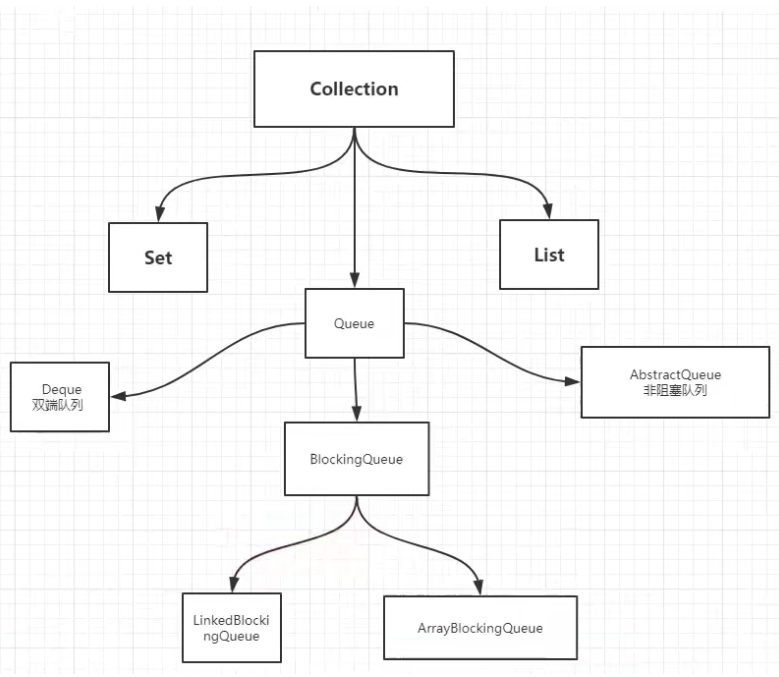

blockingQueue 是Collection的一个子类;

什么情况我们会使用 阻塞队列呢?

多线程并发处理、线程池!

整个阻塞队列的家族如下:Queue以下实现的有Deque、AbstaractQueue、BlockingQueue;

BlockingQueue以下有Link链表实现的阻塞队列、也有Array数组实现的阻塞队列

BlockingQueue 的使用操作:添加、移除

但是实际我们要学的有这4组API

方式

抛出异常

不会抛出异常,有返回值

阻塞 等待

超时 等待

添加

add

offer

put

offer(timenum,timeUnit)

移除

remove

poll

take

poll(timenum,timeUnit)

判断队列首

element

peek

-

-

BlockingQueue核心方法

概述

抛出异常

当阻塞队列满时,再往队列里ad d插入元素会抛llegalStateException:Queue full

特殊值

插入方法,成功ture失败false

一直阻塞

当阻塞队列满时,生产者线程继续往队列里put元素,队列会直阻塞生产者线程直到put数据or响应中断退出

超时退出

当阻塞队列满时,队列会阻塞生产者线程定时间,超过限时后生产者线程会退出

public static void test1 () { ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue <>(3 ); System.out.println(blockingQueue.add("a" )); System.out.println(blockingQueue.add("b" )); System.out.println(blockingQueue.add("c" )); System.out.println(blockingQueue.remove()); System.out.println(blockingQueue.remove()); System.out.println(blockingQueue.remove()); System.out.println(blockingQueue.remove()); } ======================================================================================= public static void test2 () { ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue <>(3 ); System.out.println(blockingQueue.offer("a" )); System.out.println(blockingQueue.offer("b" )); System.out.println(blockingQueue.offer("c" )); System.out.println(blockingQueue.offer("d" )); System.out.println(blockingQueue.poll()); System.out.println(blockingQueue.poll()); System.out.println(blockingQueue.poll()); System.out.println(blockingQueue.poll()); } ======================================================================================= public static void test3 () throws InterruptedException { ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue <>(3 ); blockingQueue.put("a" ); blockingQueue.put("b" ); blockingQueue.put("c" ); System.out.println(blockingQueue.take()); System.out.println(blockingQueue.take()); System.out.println(blockingQueue.take()); System.out.println(blockingQueue.take()); } ======================================================================================= public static void test4 () throws InterruptedException { ArrayBlockingQueue blockingQueue = new ArrayBlockingQueue <>(3 ); blockingQueue.offer("a" ); blockingQueue.offer("b" ); blockingQueue.offer("c" ); System.out.println("开始等待" ); blockingQueue.offer("d" ,2 , TimeUnit.SECONDS); System.out.println("结束等待" ); System.out.println("===========取值==================" ); System.out.println(blockingQueue.poll()); System.out.println(blockingQueue.poll()); System.out.println(blockingQueue.poll()); System.out.println("开始等待" ); blockingQueue.poll(2 ,TimeUnit.SECONDS); System.out.println("结束等待" ); }

常见的 BlockingQueue ArrayBlockingQueue 由数组结构组成的有界阻塞队列。

LinkedBlockingQueue 由链表结构组成的有界(但大小默认值为integer.MAX_VALUE)阻塞队列

对比 ArrayBlockingQueue 和 LinkedBlockingQueue 是两个最普通也是最常用的阻塞队列,一般情况下,在处理多线程间的生产者消费者问题,使用这两个类足以。

DelayQueue 使用优先级队列实现的延迟无界阻塞队列。

PriorityBlockingQueue 一句话总结: 支持优先级排序的无界阻塞队列。

SynchronousQueue 不存储元素的阻塞队列,也即单个元素的队列。

LinkedTransferQueue 由链表组成的无界阻塞队列

LinkedBlockingDeque 由链表组成的双向阻塞队列

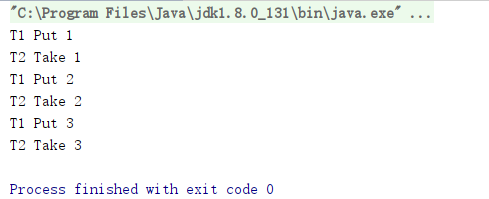

SynchronousQueue同步队列 同步队列没有容量,也可以视为容量为1的队列;进去一个元素,必须等待取出来之后,才能再往里面放入一个元素;

put方法 和 take方法;

Synchronized和其他的BlockingQueue不一样它不存储元素;put了一个元素,就必须从里面先take出来,否则不能再put进去值!

并且SynchronousQueue的take是使用了lock锁保证线程安全的。

public class SynchronousQueueDemo { public static void main (String[] args) { BlockingQueue<String> synchronousQueue = new SynchronousQueue <>(); new Thread (()->{ try { System.out.println(Thread.currentThread().getName()+" Put 1" ); synchronousQueue.put("1" ); System.out.println(Thread.currentThread().getName()+" Put 2" ); synchronousQueue.put("2" ); System.out.println(Thread.currentThread().getName()+" Put 3" ); synchronousQueue.put("3" ); } catch (InterruptedException e) { e.printStackTrace(); } },"T1" ).start(); new Thread (()->{ try { System.out.println(Thread.currentThread().getName()+" Take " +synchronousQueue.take()); System.out.println(Thread.currentThread().getName()+" Take " +synchronousQueue.take()); System.out.println(Thread.currentThread().getName()+" Take " +synchronousQueue.take()); } catch (InterruptedException e) { e.printStackTrace(); } },"T2" ).start(); } }

运行结果

公平模式和非公平模式的区别: 声明一个 SynchronousQueue 有两种不同的方式

公平模式:SynchronousQueue 会采用公平锁,并配合一个 FIFO 队列来阻塞多余的生产者和消费者,从而体系整体的公平策略;

非公平模式(SynchronousQueue 默认):SynchronousQueue 采用非公平锁,同时配合一个 LIFO 队列来管理多余的生产者和消费者,而后一种模式,如果生产者和消费者的处理速度有差距,则很容易出现饥渴的情况,即可能有某些生产者或者是消费者的数据永远都得不到处理。

小结

在多线程领域:所谓阻塞,在某些情况下会挂起线程(即阻塞),一旦条件满足,被挂起的线程又会自动被唤起 为什么需要BlockingQueue? 在concurrent包发布以前,在多线程环境下,我们每个程序员都必须去自己控制这些细节,尤其还要兼顾效率和线程安全,而这会给我们的程序带来不小的复杂度。使用后我们不需要关心什么时候需要阻塞线程,什么时候需要唤醒线程,因为这一切BlockingQueue都给你一手包办了

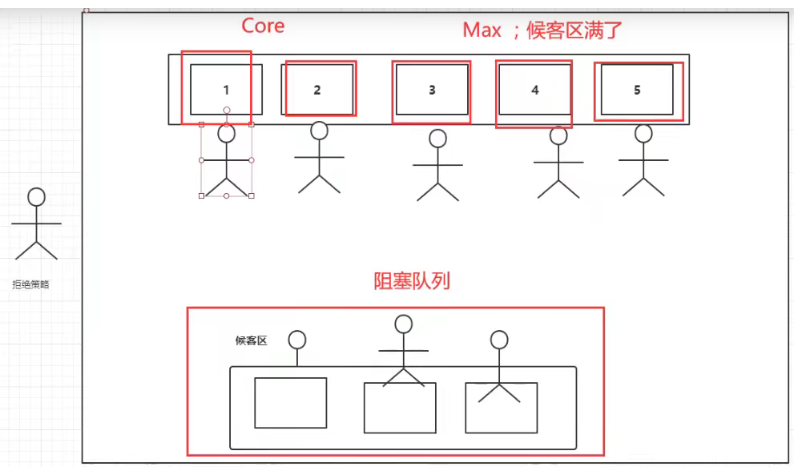

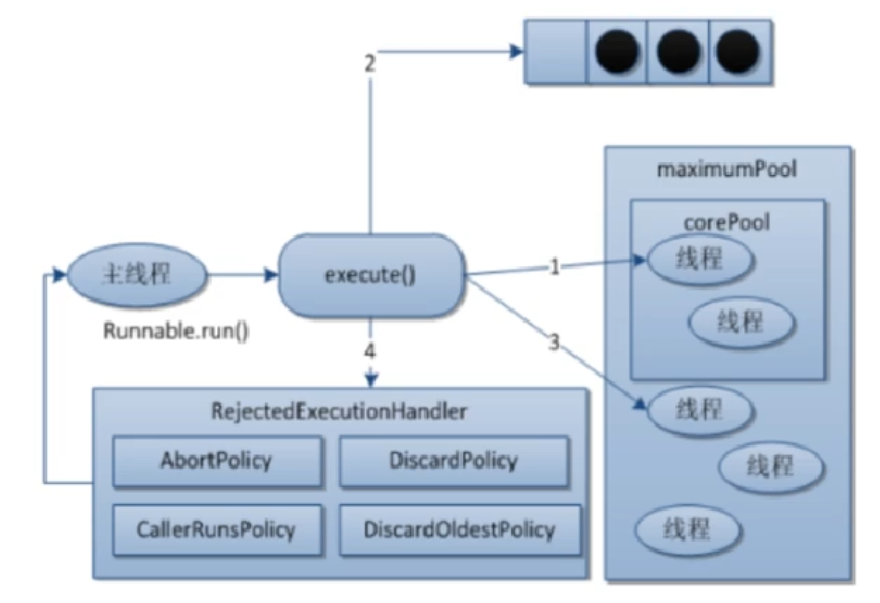

10、ThreadPool 线程池 ==三大方法、7大参数、4种拒绝策略==

池化技术 程序的运行,本质:占用系统的资源!我们需要去优化资源的使用 ===> 池化技术

线程池、JDBC的连接池、内存池、对象池等等。。。。

资源的创建、销毁十分消耗资源

池化技术:事先准备好一些资源,如果有人要用,就来我这里拿,用完之后还给我,以此来提高效率。

线程池的优势:线程池做的工作只要是控制运行的线程数量,处理过程中将任务放入队列,然后在线程创建后启动这些任务,如果线程数量超过了最大数量,超出数量的线程排队等候,等其他线程执行完毕,再从队列中取出任务来执行。

线程池的好处:

降低资源的消耗:通过重复利用已创建的线程降低线程创建和销毁造成的销耗。

提高响应的速度:当任务到达时,任务可以不需要等待线程创建就能立即执行。

提高线程的可管理性:线程是稀缺资源,如果无限制的创建,不仅会销耗系统资源,还会降低系统的稳定性,使用线程池可以进行统一-的分配, 调优和监控。

线程复用、可以控制最大并发数、管理线程;

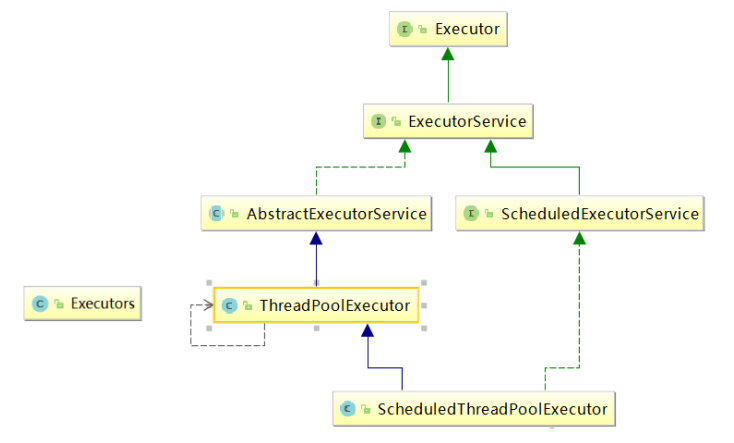

Java中的线程池是通过Executor框架实现的,该框架中用到了Executor, Executors,ExecutorService, ThreadPoolExecutor 这几个类

三大方法

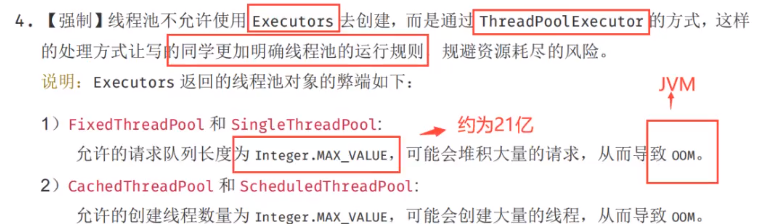

ExecutorService threadPool = Executors.newSingleThreadExecutor();//单线程的线程池

ExecutorService threadPool2 = Executors.newFixedThreadPool(5); //创建一个固定的线程池的大小

ExecutorService threadPool3 = Executors.newCachedThreadPool(); //可伸缩的(可缓冲的线程池)

newScheduledThreadPool();//不限制线程数量的线程池,可周期性的执行某个业务

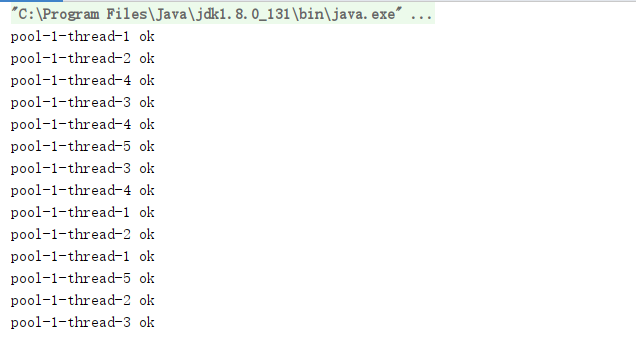

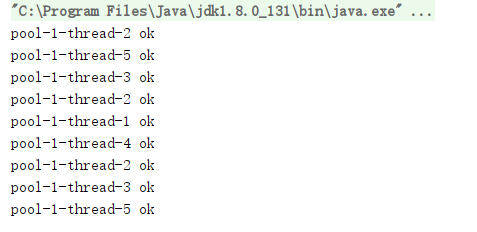

public class Demo01 { public static void main (String[] args) { ExecutorService threadPool = Executors.newSingleThreadExecutor(); ExecutorService threadPool2 = Executors.newFixedThreadPool(5 ); ExecutorService threadPool3 = Executors.newCachedThreadPool(); try { for (int i = 1 ; i <=100 ; i++) { threadPool.execute(()->{ System.out.println(Thread.currentThread().getName()+ " ok" ); }); } } catch (Exception e) { e.printStackTrace(); } finally { threadPool.shutdown(); } } }

七大参数

corePoolSize线程池的核心线程数

maximumPoolSize能容纳的最大线程数

keepAlive Time空闲线程存活时间

unit存活的时间单位

workQueue存放提交但未执行任务的队列

threadFactory创建线程的工厂类

handler等待队列满后的拒绝策略

源码分析

public static ExecutorService newSingleThreadExecutor () { return new FinalizableDelegatedExecutorService (new ThreadPoolExecutor (1 , 1 , 0L , TimeUnit.MILLISECONDS, new LinkedBlockingQueue <Runnable>())); }

public static ExecutorService newFixedThreadPool (int nThreads) { return new ThreadPoolExecutor (nThreads, nThreads, 0L , TimeUnit.MILLISECONDS, new LinkedBlockingQueue <Runnable>()); }

public static ExecutorService newCachedThreadPool () { return new ThreadPoolExecutor (0 , Integer.MAX_VALUE, 60L , TimeUnit.SECONDS, new SynchronousQueue <Runnable>()); }

本质:三种方法都是开启的ThreadPoolExecutor

public ThreadPoolExecutor (int corePoolSize, //核心线程池大小 int maximumPoolSize, //最大的线程池大小 long keepAliveTime, //超时了没有人调用就会释放 TimeUnit unit, //超时单位 BlockingQueue<Runnable> workQueue, //阻塞队列 ThreadFactory threadFactory, //线程工厂 创建线程的 一般不用动 RejectedExecutionHandler handler //拒绝策略 ) { if (corePoolSize < 0 || maximumPoolSize <= 0 || maximumPoolSize < corePoolSize || keepAliveTime < 0 ) throw new IllegalArgumentException (); if (workQueue == null || threadFactory == null || handler == null ) throw new NullPointerException (); this .corePoolSize = corePoolSize; this .maximumPoolSize = maximumPoolSize; this .workQueue = workQueue; this .keepAliveTime = unit.toNanos(keepAliveTime); this .threadFactory = threadFactory; this .handler = handler; }

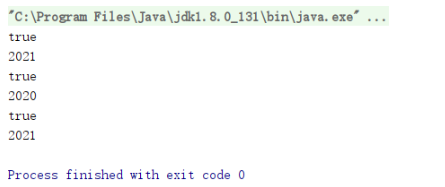

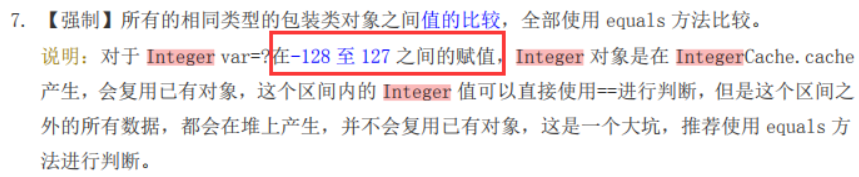

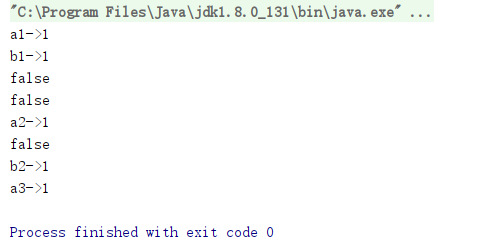

阿里巴巴的Java操作手册中明确说明:对于Integer.MAX_VALUE初始值较大,所以一般情况我们要使用底层的ThreadPoolExecutor 来创建线程池。

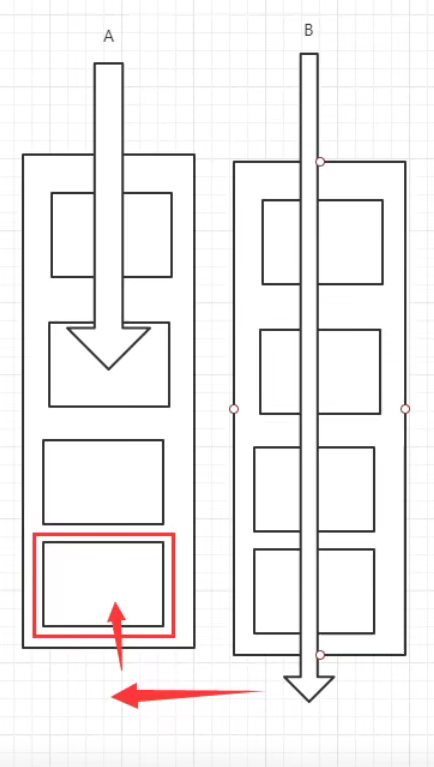

业务图

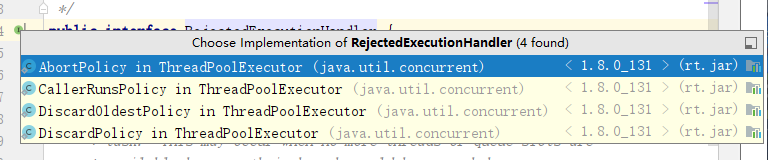

四种拒绝策略 当提交的任务数大于(workQueue.size() + maximumPoolSize ),就会触发线程池的拒绝策略 。

CallerRunsPolicy: 当触发拒绝策略,只要线程池没有关闭的话,则使用调用线程直接运行任务。一般并发比较小,性能要求不高,不允许失败。但是,由于调用者自己运行任务,如果任务提交速度过快,可能导致程序阻塞,性能效率上必然的损失较大

AbortPolicy:丢弃任务,并抛出拒绝执行RejectedExecutionException异常信息。线程池默认的拒绝策略。必须处理好抛出的异常,否则会打断当前的执行流程,影响后续的任务执行。

DiscardPolicy:直接丢弃,其他啥都没有

DiscardOldestPolicy:当触发拒绝策略,只要线程池没有关闭的话,丢弃阻塞队列workQueue中最老的一个任务,并将新任务加入

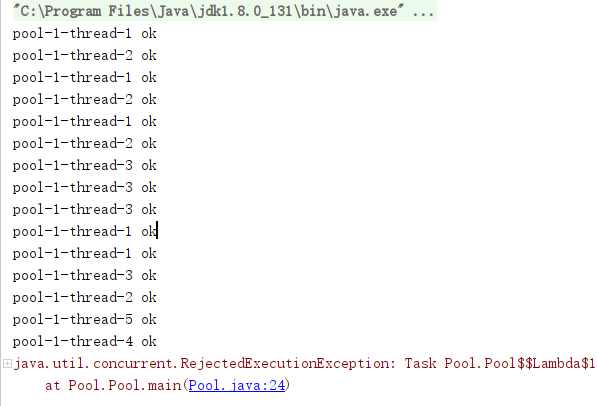

(1)new ThreadPoolExecutor.AbortPolicy(): //该拒绝策略为:银行满了,还有人进来,不处理这个人的,并抛出异常

超出最大承载,就会抛出异常:队列容量大小+maxPoolSize

public class Pool { public static void main (String[] args) { ExecutorService threadPool = new ThreadPoolExecutor ( 2 , 5 , 3 , TimeUnit.SECONDS, new LinkedBlockingDeque <>(3 ), Executors.defaultThreadFactory(), new ThreadPoolExecutor .AbortPolicy() ); try { for (int i = 1 ; i <=100 ; i++) { threadPool.execute(()->{ System.out.println(Thread.currentThread().getName()+ " ok" ); }); } } catch (Exception e) { e.printStackTrace(); } finally { threadPool.shutdown(); } } }

运行结果

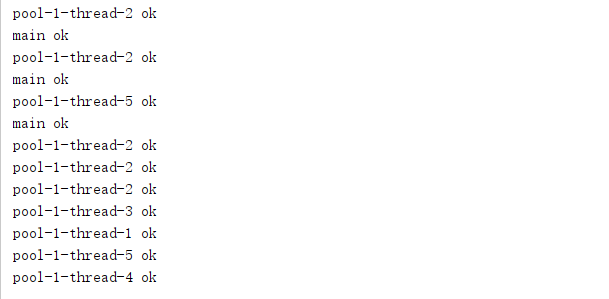

(2)new ThreadPoolExecutor.CallerRunsPolicy(): //该拒绝策略为:哪来的去哪里 main线程进行处理

public class Pool { public static void main (String[] args) { ExecutorService threadPool = new ThreadPoolExecutor ( 2 , 5 , 3 , TimeUnit.SECONDS, new LinkedBlockingDeque <>(3 ), Executors.defaultThreadFactory(), new ThreadPoolExecutor .CallerRunsPolicy() ); try { for (int i = 1 ; i <=100 ; i++) { threadPool.execute(()->{ System.out.println(Thread.currentThread().getName()+ " ok" ); }); } } catch (Exception e) { e.printStackTrace(); } finally { threadPool.shutdown(); } } }

运行结果

(3)new ThreadPoolExecutor.DiscardPolicy(): //该拒绝策略为:队列满了,丢掉异常,不会抛出异常。

public class Pool { public static void main (String[] args) { ExecutorService threadPool = new ThreadPoolExecutor ( 2 , 5 , 3 , TimeUnit.SECONDS, new LinkedBlockingDeque <>(3 ), Executors.defaultThreadFactory(), new ThreadPoolExecutor .DiscardPolicy() ); try { for (int i = 1 ; i <=100 ; i++) { threadPool.execute(()->{ System.out.println(Thread.currentThread().getName()+ " ok" ); }); } } catch (Exception e) { e.printStackTrace(); } finally { threadPool.shutdown(); } } }

运行结果

(4)new ThreadPoolExecutor.DiscardOldestPolicy(): //该拒绝策略为:队列满了,尝试去和最早的进程竞争,不会抛出异常

public class Pool { public static void main (String[] args) { ExecutorService threadPool = new ThreadPoolExecutor ( 2 , 5 , 3 , TimeUnit.SECONDS, new LinkedBlockingDeque <>(3 ), Executors.defaultThreadFactory(), new ThreadPoolExecutor .DiscardOldestPolicy() ); try { for (int i = 1 ; i <=100 ; i++) { threadPool.execute(()->{ System.out.println(Thread.currentThread().getName()+ " ok" ); }); } } catch (Exception e) { e.printStackTrace(); } finally { threadPool.shutdown(); } } }

运行结果

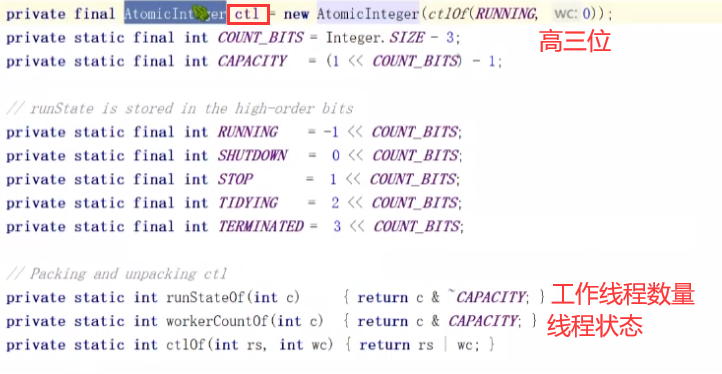

CTL属性

是线程池中的一个属性,本质就是int类型的属性

高3位描述的是线程池的状态,低29位是描述工作线程的状态,来确认任务是否需要执行(以那种方式执行)

低29表述线程池中现存的工作线程数量

execute中的addwork方法就是添加工作线程的方法

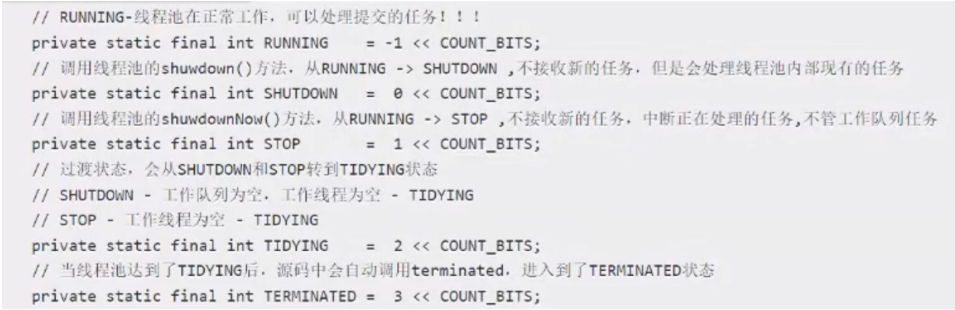

线程池的状态 running——正常运行

shutdown——由running状态转换而成。不处理新任务,但是会处理现有的任务

stop——由running状态转换而成。不处理新任务,现有任务也停止

tidying——由shutdown、stop状态转换而成。作为停止前的中间态(马上就要停止了)

terminated——由tidying状态转换而成。在进入tidying状态后,源码中会自动化调用terminated方法。彻底结束

常见问题 在线程池中什么是工作线程 在java的线程池中,工作线程指的是worker对象

addwork(runnalbe,true /false );

worker对象其实是线程池中的一个内部类,继承了AQS,实现了runnable

private final class Worker extends AbstractQueuedSynchronizer implements Runnable {}

线程池执行任务,实际调用的是worker类中的run方法内部的runworker方法

worker继承AQS的目的是为了添加标识来判断当前工作线程是否可以被打断

工作线程存储在哪个位置? 放在了hashset集合中——workers

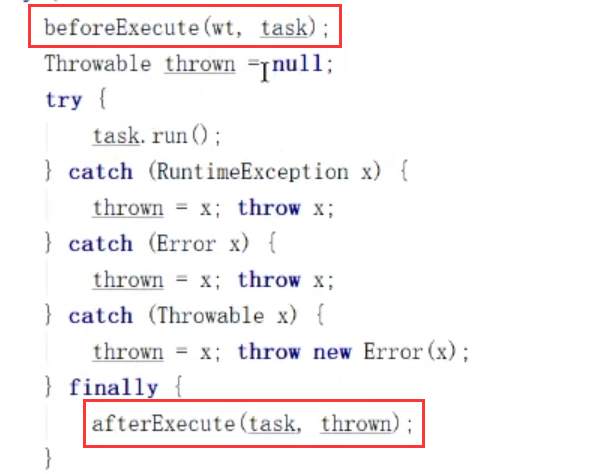

如何在线程池执行任务前后做额外处理? 实现线程池,然后实现这两个方法

如何合理的分配线程池大小? hippo4j 运维用的多

在分配线程池容量大小时,必须要根据你的业务类型来决定。

IO密集型?CPU密集型?混合型?

CPI密集型:更多的CPU来计算,一直工作

IO密集型:更多的时候线程在等待响应

混合型:啥任务都有

CPU密集型:线程数少一点,CPU内核数+1

IO密集型:线程数多一点,CPU内核数 * 2 (线程等待时间与线程CPU时间之比+1)*CPU数目

为了压测时,可以动态的监控线程池运行情况以及动态修改线程池内部的核心属性。可以基于线程池提供配置参数get、set方法,动态的调整入参进行判别

基于set修改核心属性时,不需要额外的操作,线程池支持动态修改

如果存在临界资源,如何保证线程的安全性?

加互斥锁

sync、lock

非阻塞锁

cas(真的无锁吗?java层面没锁,c++层面有)

不采用锁

threadlocal,适当的情况下采用volatile也行!

让多个线程将共享资源copy到本地,就没有多线程操作共享资源的问题

volatile:只要不包含并发对共享数据进行运算(写),基本没问题

线程池线程复用的原理是什么? 线程会包装成worker对象执行任务,执行结束后通过while调用getTask方法继续获取任务,获取不到任务就会跳出循环

getTask方法中会对allowCoreThreadTimeOut判定,若设置了超时时间,超时就会被回收;若没有设置超时时间从工作队列中获取,获取不到就会等待。

小结 工作原理

在创建了线程池后,线程池中的线程数为零

当调用execute()方法添加一个请求任务时,线程池会做出如下判断:

如果正在运行的线程数量小于corePoolSize,那么马上创建线程运行这个任务;

如果正在运行的线程数量大于或等于corePoolSize,那么将这个任务放入队列;

如果这个时候队列满了且正在运行的线程数量还小于

如果队列满了且正在运行的线程数量大于或等于maximumPoolSize,那么线程池会启动饱和拒绝策略来执行。

当一个线程完成任务时,它会从队列中取下一个任务来执行

当一个线程无事可做超过一定的时间(keepAliveTime) 时,线程会判断:

如果当前运行的线程数大于corePoolSize,那么这个线程就被停掉。

所以线程池的所有任务完成后,它最终会收缩到corePoolSize的大小。

CPU密集型和IO密集型 如何去设置线程池的最大大小如何去设置?

CPU密集型 电脑的核数是几核就选择几;选择maximunPoolSize的大小

我们可以使用代码来来获取逻辑处理器数量。

于是cpu密集型 的写法如下:

ExecutorService threadPool = new ThreadPoolExecutor ( 2 , Runtime.getRuntime().availableProcessors(), 3 , TimeUnit.SECONDS, new LinkedBlockingDeque <>(3 ), Executors.defaultThreadFactory(), new ThreadPoolExecutor .AbortPolicy() );

IO密集型 在程序中有15个大型任务,io十分占用资源;I/O密集型就是判断我们程序中十分耗I/O的线程数量,大约是最大I/O数的一倍到两倍之间。

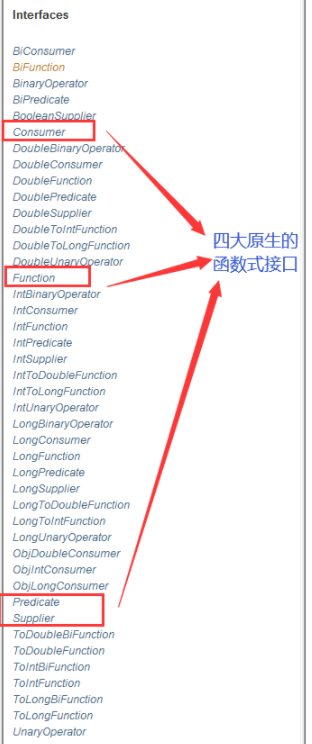

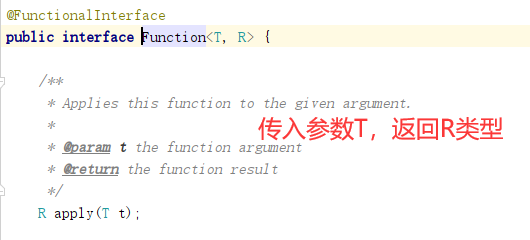

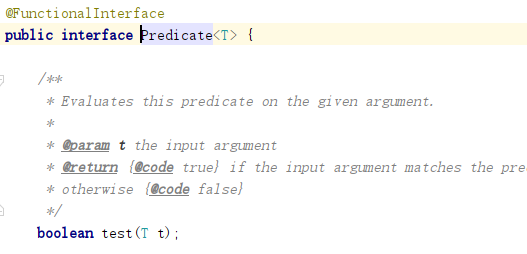

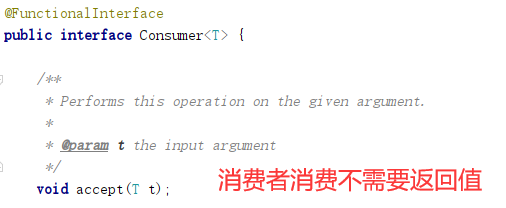

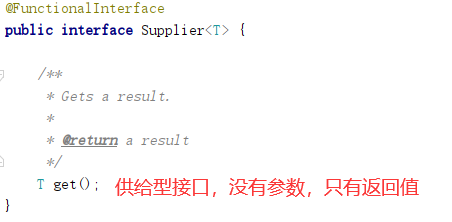

11、四大函数式接口 新时代的程序员:lambda表达式、链式编程、函数式接口、Stream流式计算

函数式接口:只有一个方法的接口 @FunctionalInterface public interface Runnable { public abstract void run () ; }

函数型接口可以使用lambda表达式;

Function函数型接口 public class Demo1 { public static void main (String[] args) { Function<String, String> function = (str) -> { return str; }; System.out.println(function.apply("starasdas" )); } }

Predicate断定型接口 public class Demo2 { public static void main (String[] args) { Predicate<String> predicate = (str)->{return str.isEmpty();}; System.out.println(predicate.test("11" )); System.out.println(predicate.test("" )); } }

Consummer 消费型接口 public class Demo3 { public static void main (String[] args) { Consumer<String> consumer = (str)->{ System.out.println(str); }; consumer.accept("abc" ); } }

Supplier供给型接口 public class Demo4 { public static void main (String[] args) { Supplier<String> supplier = ()->{return "1024" ;}; System.out.println(supplier.get()); } }

12、Stream流计算 概述 存储 :集合、MySQL

计算 :流式计算~

链式编程 题目要求

一分钟内完成此题,只能用一行代码实现!

现在有5个用户,筛选:

1、ID必须是偶数

2、年龄必须大于23岁

3、用户名转为大写字母

4、用户名字母倒着排序

5、只输出一个用户!

public class Test { public static void main (String[] args) { User user1 = new User (1 ,"a" ,21 ); User user2 = new User (2 ,"b" ,22 ); User user3 = new User (3 ,"c" ,23 ); User user4 = new User (4 ,"d" ,24 ); User user5 = new User (5 ,"e" ,25 ); User user6 = new User (6 ,"f" ,26 ); List<User> list = Arrays.asList(user1, user2, user3, user4, user5, user6); list.stream() .filter((u)->{ return u.getId()%2 ==0 ; }) .filter((u)->{return u.getAge()>23 ;}) .map((u)->{return u.getName().toUpperCase();}) .sorted((uu1,uu2)->{ return uu2.compareTo(uu1); }) .limit(1 ) .forEach(System.out::println); } }

13、Fork/Join 框架 概述 Fork/Join 它可以将一个大的任务拆分成多个子任务进行并行处理,最后将子任务结果合并成最后的计算结果,并进行输出。Fork/Join 框架要完成两件事情:

Fork:把一个复杂任务进行分析,大事化小

Join:把拆分任务的结果进行合并

大数据中:MapReduce 核心思想->把大任务拆分为小任务!

ForkJoin 特点 工作窃取!

实现原理是:双端队列 !从上面和下面都可以去拿到任务进行执行!

ForkJoin的使用

通过ForkJoinPool 来执行

计算任务 execute(ForkJoinTask<?> task)

计算类要去继承ForkJoinTask;

ForkJoinTask:我们要使用Fork/Join 框架,首先需要创建一个ForkJoin任务。该类提供了在任务中执行fork和join的机制。通常情况下我们不需要直接集成ForkJoinTask类,只需要继承它的子类,Fork/Join 框架提供了两个子类:

a.RecursiveAction:用于没有返回结果的任务

b.Recursive Task:用于有返回结果的任务

ForkJoinPool:ForkJoinTask需要通过ForkJoinPool来执行

RecursiveTask:继承后可以实现递归(自己调自己)调用的任务

Fork/Join框架的实现原理

ForkJoinPool由ForkJoinTask数组和ForkJoinWorkerThread数组组成,ForkJoinTask数组负责将存放以及将程序提交给ForkJoinPool,而ForkJoinWorkerThread负责执行这些任务。

实例 import java.util.concurrent.RecursiveTask;public class ForkJoinDemo extends RecursiveTask <Long> { private long star; private long end; private long temp=1000000L ; public ForkJoinDemo (long star, long end) { this .star = star; this .end = end; } @Override protected Long compute () { if ((end-star)<temp){ Long sum = 0L ; for (Long i = star; i < end; i++) { sum+=i; } return sum; }else { long middle = (star+ end)/2 ; ForkJoinDemo forkJoinDemoTask1 = new ForkJoinDemo (star, middle); forkJoinDemoTask1.fork(); ForkJoinDemo forkJoinDemoTask2 = new ForkJoinDemo (middle, end); forkJoinDemoTask2.fork(); long taskSum = forkJoinDemoTask1.join() + forkJoinDemoTask2.join(); return taskSum; } } }

测试类

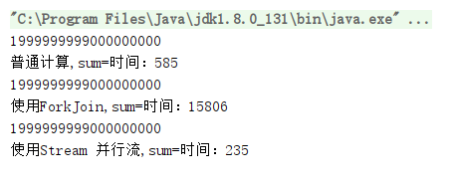

import java.util.concurrent.ExecutionException;import java.util.concurrent.ForkJoinPool;import java.util.concurrent.ForkJoinTask;import java.util.stream.LongStream;public class Test { public static void main (String[] args) throws ExecutionException, InterruptedException { test1(); test2(); test3(); } public static void test1 () { long star = System.currentTimeMillis(); long sum = 0L ; for (long i = 1 ; i < 20_0000_0000 ; i++) { sum+=i; } long end = System.currentTimeMillis(); System.out.println(sum); System.out.println("普通计算,sum=" +"时间:" +(end-star)); } public static void test2 () throws ExecutionException, InterruptedException { long star = System.currentTimeMillis(); ForkJoinPool forkJoinPool = new ForkJoinPool (); ForkJoinTask<Long> task = new ForkJoinDemo (0L , 20_0000_0000L ); ForkJoinTask<Long> submit = forkJoinPool.submit(task); Long aLong = submit.get(); System.out.println(aLong); long end = System.currentTimeMillis(); System.out.println("使用ForkJoin,sum=" +"时间:" +(end-star)); } public static void test3 () { long star = System.currentTimeMillis(); long sum = LongStream.range(0L , 20_0000_0000L ).parallel().reduce(0 , Long::sum); System.out.println(sum); long end = System.currentTimeMillis(); System.out.println("使用Stream 并行流,sum=" +"时间:" +(end-star)); } }

运行结果

Fork/Join的异常处理 ForkJoinTask在执行的时候可能会抛出异常,但是我们没办法在主线程里直接捕获异常,所以ForkJoinTask提供了isCompletedAbnormally()方法来检查任务是否已经抛出异常或已经被取消了,并且可以通过ForkJoinTask的getException方法获取异常。

getException方法返回Throwable对象,如果任务被取消了则返回CancellationException。如果任务没有完成或者没有抛出异常则返回null。

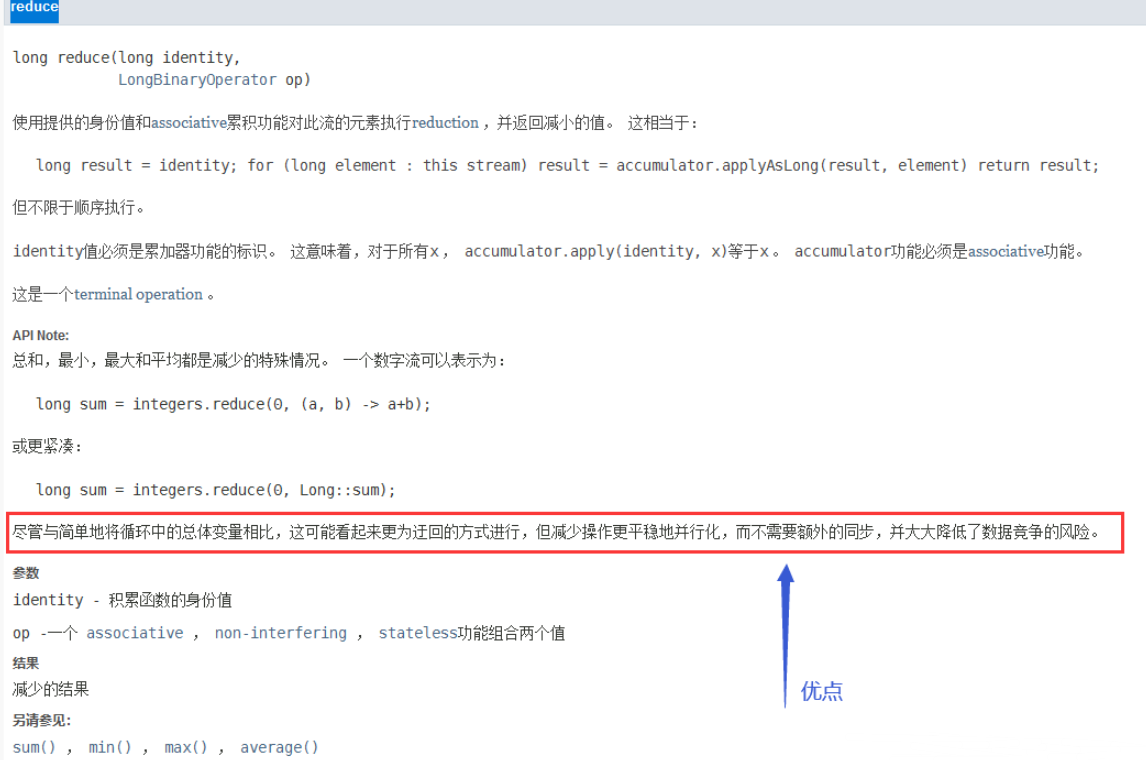

.parallel().reduce(0, Long::sum)使用一个并行流去计算整个计算,提高效率。

reduce方法的优点:

14、异步回调 Future Future 设计的初衷:对将来的某个事件结果进行建模!

主要缺点

不支持手动完成

我提交了一个任务,但是执行太慢了,我通过其他路径已经获取到了任务结果,现在没法把这个任务结果通知到正在执行的线程,所以必须主动取消或者一直待它执行完成

不支持进一步的非阻塞调用

通过 Future 的 get 方法会一直阻塞到任务完成,但是想在获取任务之后执行额外的任务,因为 Future 不支持回调函数,所以无法实现这个功能

不支持链式调用

对于 Future 的执行结果,我们想继续传到下一个Future 处理使用,从而形成一个链式的pipline调用,这在Future中是没法实现的。

不支持多个Future合并

比如我们有 10 个 Future 并行执行,我们想在所有的 Future 运行完毕之后,执行某些函数,是没法通过 Future 实现的。

不支持异常处理

Future的API没有任何的异常处理的api,所以在异步运行时,如果出了问题是不好定位的。

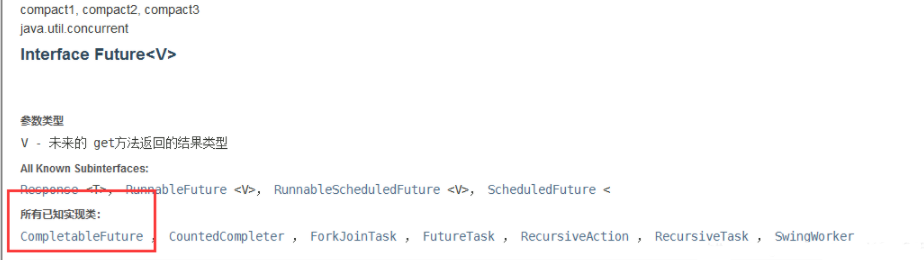

CompletableFuture 但是我们平时都使用CompletableFuture

CompletableFuture在Java里面被用于异步编程,异步通常意味着非阻塞,可以使得我们的任务单独运行在与主线程分离的其他线程中,并且通过回调可以在主线程中得到异步任务的执行状态,是否完成,和是否异常等信息。

CompletableFuture实现了Future, CompletionStage接口,实现了Future接日就可以兼容现在有线程池框架,而CompletionStage接口才是异步编程的接口抽象,里面定义多种异步方法,通过这两者集合,从而打造出了强大的CompletableFuture类。

常用方法 CompletableFuture 同时实现了 Future 和 CompletionStage 接口。

public class CompletableFuture <T> implements Future <T>, CompletionStage<T> {}

CompletableFuture 除了提供了更为好用和强大的 Future 特性之外,还提供了函数式编程的能力。

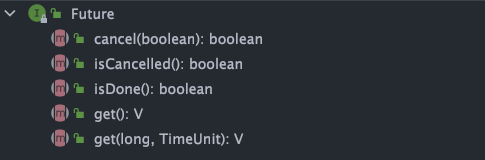

Future 接口有 5 个方法:

boolean cancel(boolean mayInterruptIfRunning) :尝试取消执行任务。boolean isCancelled() :判断任务是否被取消。boolean isDone() : 判断任务是否已经被执行完成。get() :等待任务执行完成并获取运算结果。get(long timeout, TimeUnit unit) :多了一个超时时间。

CompletionStage<T> 接口中的方法比较多,CompletableFuture 的函数式能力就是这个接口赋予的。从这个接口的方法参数你就可以发现其大量使用了 Java8 引入的函数式编程。

CompletableFuture入门 使用CompletableFuture 主线程里面创建一个CompletableFuture,然后主线程调用get方法会阻塞,最后我们在一个子线程中使其终止。

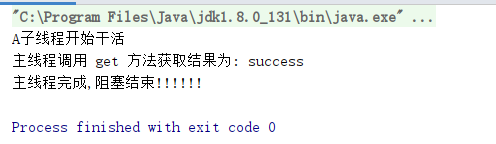

public class Test01 { public static void main (String[] args) throws Exception { CompletableFuture<String> future = new CompletableFuture <>(); new Thread (() -> { try { System.out.println(Thread.currentThread().getName() + "子线程开始干活" ); Thread.sleep(5000 ); future.complete("success" ); } catch (Exception e) { e.printStackTrace(); } }, "A" ).start(); System.out.println("主线程调用 get 方法获取结果为: " + future.get()); System.out.println("主线程完成,阻塞结束!!!!!!" ); } }

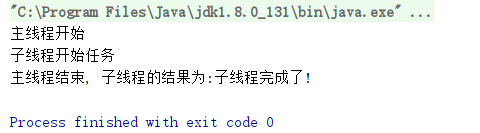

没有返回值的异步回调——runAsync test01 public static void main (String[] args) throws ExecutionException, InterruptedException { System.out.println(System.currentTimeMillis()); System.out.println("---------------------" ); CompletableFuture<Void> future = CompletableFuture.runAsync(()->{ try { TimeUnit.SECONDS.sleep(2 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println(Thread.currentThread().getName()+"....." ); }); System.out.println(System.currentTimeMillis()); System.out.println("------------------------------" ); System.out.println(future.get()); }

test02 public static void main (String[] args) throws ExecutionException, InterruptedException { System.out.println(System.currentTimeMillis()); System.out.println("---------------------" ); CompletableFuture<Void> future = CompletableFuture.runAsync(()->{ try { TimeUnit.SECONDS.sleep(2 ); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println(Thread.currentThread().getName()+"....." ); }); System.out.println(System.currentTimeMillis()); System.out.println("------------------------------" ); System.out.println(future.get()); }

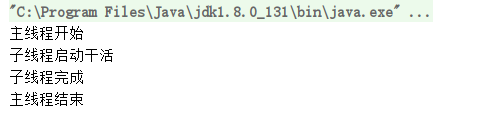

有返回值的异步回调supplyAsync test01 public class Test03 { public static void main (String[] args) throws Exception { System.out.println("主线程开始" ); CompletableFuture<String> future = CompletableFuture.supplyAsync(() -> { try { System.out.println("子线程开始任务" ); Thread.sleep(5000 ); } catch (Exception e) { e.printStackTrace(); } return "子线程完成了!" ; }); String s = future.get(); System.out.println("主线程结束, 子线程的结果为:" + s); } }

test02 CompletableFuture<Integer> completableFuture=CompletableFuture.supplyAsync(()->{ System.out.println(Thread.currentThread().getName()); try { TimeUnit.SECONDS.sleep(2 ); int i=1 /0 ; } catch (InterruptedException e) { e.printStackTrace(); } return 1024 ; }); System.out.println(completableFuture.whenComplete((t, u) -> { System.out.println("t=>" + t); System.out.println("u=>" + u); }).exceptionally((e) -> { System.out.println(e.getMessage()); return 404 ; }).get());

whenComplete : 有两个参数,一个是t 一个是u

T:是代表的 正常返回的结果 ;

U:是代表的 抛出异常的错误信息 ;

如果发生了异常,get可以获取到exceptionally 返回的值;

线程依赖 当一个线程依赖另一个线程时,可以使用 thenApply 方法来把这两个线程串行化。

public class Test04 { private static Integer num = 10 ; public static void main (String[] args) throws Exception { System.out.println("主线程开始" ); CompletableFuture<Integer> future = CompletableFuture.supplyAsync(() -> { try { System.out.println("加 10 任务开始" ); num += 10 ; } catch (Exception e) { e.printStackTrace(); } return num; }).thenApply(integer -> { return num * num; }); Integer integer = future.get(); System.out.println("主线程结束, 子线程的结果为:" + integer); } }

消费处理结果 thenAccept 消费处理结果,接收任务的处理结果,并消费处理,无返回结果。

public class Test05 { private static Integer num = 10 ; public static void main (String[] args) throws Exception { System.out.println("主线程开始" ); CompletableFuture.supplyAsync(() -> { try { System.out.println("加 10 任务开始" ); num += 10 ; } catch (Exception e) { e.printStackTrace(); } return num; }).thenApply(integer -> { return num * num; }).thenAccept(new Consumer <Integer>() { @Override public void accept (Integer integer) { System.out.println("子线程全部处理完成,最后调用了 accept,结果为:" + integer); } }); } }

处理异步结算的结果 当我们获取到异步计算的结果之后,还可以对其进行进一步的处理,比较常用的方法有下面几个:

thenApply()thenAccept()thenRun()whenComplete()

thenApply() 方法接受一个 Function 实例,用它来处理结果。

public <U> CompletableFuture<U> thenApply ( Function<? super T,? extends U> fn) { return uniApplyStage(null , fn); } public <U> CompletableFuture<U> thenApplyAsync ( Function<? super T,? extends U> fn) { return uniApplyStage(defaultExecutor(), fn); } public <U> CompletableFuture<U> thenApplyAsync ( Function<? super T,? extends U> fn, Executor executor) { return uniApplyStage(screenExecutor(executor), fn); }

thenApply() 方法使用示例如下:

CompletableFuture<String> future = CompletableFuture.completedFuture("hello!" ) .thenApply(s -> s + "world!" ); assertEquals("hello!world!" , future.get()); future.thenApply(s -> s + "nice!" ); assertEquals("hello!world!" , future.get());

你还可以进行 流式调用 :

CompletableFuture<String> future = CompletableFuture.completedFuture("hello!" ) .thenApply(s -> s + "world!" ).thenApply(s -> s + "nice!" ); assertEquals("hello!world!nice!" , future.get());

如果你不需要从回调函数中获取返回结果,可以使用 thenAccept() 或者 thenRun()。这两个方法的区别在于 thenRun() 不能访问异步计算的结果。

thenAccept() 方法的参数是 Consumer<? super T> 。

public CompletableFuture<Void> thenAccept (Consumer<? super T> action) { return uniAcceptStage(null , action); } public CompletableFuture<Void> thenAcceptAsync (Consumer<? super T> action) { return uniAcceptStage(defaultExecutor(), action); } public CompletableFuture<Void> thenAcceptAsync (Consumer<? super T> action, Executor executor) { return uniAcceptStage(screenExecutor(executor), action); }

顾名思义,Consumer 属于消费型接口,它可以接收 1 个输入对象然后进行“消费”。

@FunctionalInterface public interface Consumer <T> { void accept (T t) ; default Consumer<T> andThen (Consumer<? super T> after) { Objects.requireNonNull(after); return (T t) -> { accept(t); after.accept(t); }; } }

thenRun() 的方法是的参数是 Runnable 。

public CompletableFuture<Void> thenRun (Runnable action) { return uniRunStage(null , action); } public CompletableFuture<Void> thenRunAsync (Runnable action) { return uniRunStage(defaultExecutor(), action); } public CompletableFuture<Void> thenRunAsync (Runnable action, Executor executor) { return uniRunStage(screenExecutor(executor), action); }

thenAccept() 和 thenRun() 使用示例如下:

CompletableFuture.completedFuture("hello!" ) .thenApply(s -> s + "world!" ).thenApply(s -> s + "nice!" ).thenAccept(System.out::println); CompletableFuture.completedFuture("hello!" ) .thenApply(s -> s + "world!" ).thenApply(s -> s + "nice!" ).thenRun(() -> System.out.println("hello!" ));

whenComplete() 的方法的参数是 BiConsumer<? super T, ? super Throwable> 。

public CompletableFuture<T> whenComplete ( BiConsumer<? super T, ? super Throwable> action) { return uniWhenCompleteStage(null , action); } public CompletableFuture<T> whenCompleteAsync ( BiConsumer<? super T, ? super Throwable> action) { return uniWhenCompleteStage(defaultExecutor(), action); } public CompletableFuture<T> whenCompleteAsync ( BiConsumer<? super T, ? super Throwable> action, Executor executor) { return uniWhenCompleteStage(screenExecutor(executor), action); }

相对于 Consumer , BiConsumer 可以接收 2 个输入对象然后进行“消费”。

@FunctionalInterface public interface BiConsumer <T, U> { void accept (T t, U u) ; default BiConsumer<T, U> andThen (BiConsumer<? super T, ? super U> after) { Objects.requireNonNull(after); return (l, r) -> { accept(l, r); after.accept(l, r); }; } }

whenComplete() 使用示例如下:

CompletableFuture<String> future = CompletableFuture.supplyAsync(() -> "hello!" ) .whenComplete((res, ex) -> { System.out.println(res); assertNull(ex); }); assertEquals("hello!" , future.get());

异常处理 你可以通过 handle() 方法来处理任务执行过程中可能出现的抛出异常的情况。

public <U> CompletableFuture<U> handle ( BiFunction<? super T, Throwable, ? extends U> fn) { return uniHandleStage(null , fn); } public <U> CompletableFuture<U> handleAsync ( BiFunction<? super T, Throwable, ? extends U> fn) { return uniHandleStage(defaultExecutor(), fn); } public <U> CompletableFuture<U> handleAsync ( BiFunction<? super T, Throwable, ? extends U> fn, Executor executor) { return uniHandleStage(screenExecutor(executor), fn); }

示例代码如下:

CompletableFuture<String> future = CompletableFuture.supplyAsync(() -> { if (true ) { throw new RuntimeException ("Computation error!" ); } return "hello!" ; }).handle((res, ex) -> { return res != null ? res : "world!" ; }); assertEquals("world!" , future.get());

你还可以通过 exceptionally() 方法来处理异常情况。

CompletableFuture<String> future = CompletableFuture.supplyAsync(() -> { if (true ) { throw new RuntimeException ("Computation error!" ); } return "hello!" ; }).exceptionally(ex -> { System.out.println(ex.toString()); return "world!" ; }); assertEquals("world!" , future.get());

如果你想让 CompletableFuture 的结果就是异常的话,可以使用 completeExceptionally() 方法为其赋值。

CompletableFuture<String> completableFuture = new CompletableFuture <>(); completableFuture.completeExceptionally( new RuntimeException ("Calculation failed!" )); completableFuture.get();

组合 CompletableFuture 你可以使用 thenCompose() 按顺序链接两个 CompletableFuture 对象。

public <U> CompletableFuture<U> thenCompose ( Function<? super T, ? extends CompletionStage<U>> fn) { return uniComposeStage(null , fn); } public <U> CompletableFuture<U> thenComposeAsync ( Function<? super T, ? extends CompletionStage<U>> fn) { return uniComposeStage(defaultExecutor(), fn); } public <U> CompletableFuture<U> thenComposeAsync ( Function<? super T, ? extends CompletionStage<U>> fn, Executor executor) { return uniComposeStage(screenExecutor(executor), fn); }

thenCompose() 方法会使用示例如下:

CompletableFuture<String> future = CompletableFuture.supplyAsync(() -> "hello!" ) .thenCompose(s -> CompletableFuture.supplyAsync(() -> s + "world!" )); assertEquals("hello!world!" , future.get());

在实际开发中,这个方法还是非常有用的。比如说,我们先要获取用户信息然后再用用户信息去做其他事情。

和 thenCompose() 方法类似的还有 thenCombine() 方法, thenCombine() 同样可以组合两个 CompletableFuture 对象。